Capítulo 10 Análise de dados experimentais

“Muito melhor uma resposta aproximada à pergunta certa, que muitas vezes é vaga, do que uma resposta exata à pergunta errada, que sempre pode ser feita com precisão.” — John Tukey

Nesta seção será abordado aspectos relacionados a análise de experimentos agrícolas, com ênfase na utilização de testes paramétricos. Esta seção será dividida em três partes principais:

Parte 1: estatistica básica: Medidas de tendência central e de variabilidade. Intervalos de confiança para média. Testes de hipóteses para verificar a igualdade entre médias de uma ou duas amostras.

Parte 2: delineamentos básicos: delineamentos experimentais inteiramente casualisado (DIC) e blocos ao acaso (DBC). Pressupostos dos modelos estatisticos. Testes complementares (média e regressão).

Parte 3: análise de covariância: Análise de covariância como uma ferramenta estatística para redução do erro experimental.

Parte 4: modelos lineares generalizados: Modelos Lineares Generalizados aplicados a análise de dados não gaussianos.

Parte 5: experimentos fatoriais: experimentos fatorias e experimentos com parcelas subdivididas.

10.1 Estatistica básica

10.1.1 Medidas de tendência central

Nesta seção mostraremos como calular medidas de tendência central e medidas de variabilidade. As medidas de tendencia central são valores que representam um conjunto de dados. Entre as mais comuns podemos citar a média, mediana e moda.

set.seed(1)

Amostra1 <- rnorm(100, 12, 3) # Gera uma amostra com distribuição normal

Amostra2 <- rpois(100, 12) # Gera uma amostra com distribuição Poisson

mean(Amostra1) # média

# [1] 12.32666

median(Amostra1) # mediana

# [1] 12.34173O R calcula a média e mediana através das funções mean() e median() , porém não calcula a moda. No blog Ridículas, mantido pelo LEG da UFPR, dois métodos são dicutidos. Incentivamos a leitura do material.

10.1.2 Medidas de variabilidade

As seguintes medidas de variabilidade podem ser computadas, com suas respectivas funções:

O desvio padrão e a variância podem ser obtidas com as funções sd() e var(), respectivamente.

sd(Amostra1)

# [1] 2.694598

var(Amostra1)

# [1] 7.260859

range(Amostra1)

# [1] 5.35590 19.20485

IQR(Amostra1)

# [1] 3.557364Não existe no R base uma função para computar o coeficiente de variação, então vamos criá-la utilizando a abordagem function():

CV <- function(dados){

if(!class(dados) == "numeric"){

stop("Os dados precisam ser numéricos")

} #Indica que os dados devem ser numéricos

media <- mean(dados)

sd <- sd(dados)

CV <- (sd/media) * 100

return(CV) # Valor que será retornado pela função

}

CV(Amostra1)

# [1] 21.85992A distribuição dos dados pode ser determinada utilizando histograma de frequências, QQ-Plos e Box-Plot (conforme visto anteriormente). Estatísticas como a amplitude, erro padrão da média, intervalo de confiança, entre outros, podem ser obtidas com a função desc_stat() do pacote metan29. Esta função permite computar as estatisticas para uma ou mais variáveis de um data frame ou um vetor de dados numéricos. Para um exemplo numérico, consulte a seção 7.3.1.

10.1.3 Resumindo dados com o pacote dplyr

Diversos verbos do pacote dplyr podem ser utilizados para resumir conjuntos de dados. Iniciaremos com a função count() para contar valores que se repetem em uma determinada variável. Por exemplo, é possível identificar qual é o valor de APLA que mais se repete utilizando

count(maize, APLA, sort = TRUE)

# # A tibble: 143 x 2

# APLA n

# <dbl> <int>

# 1 2.6 20

# 2 2.8 20

# 3 2.5 16

# 4 2 14

# 5 2.92 14

# 6 2.1 13

# 7 2.3 12

# 8 2.7 12

# 9 1.92 11

# 10 2.04 11

# # ... with 133 more rowsPara identificar quais os valores distintos de APLA foram observados a função distinct() é usada.

distinct(maize, APLA)

# # A tibble: 143 x 1

# APLA

# <dbl>

# 1 2.45

# 2 2.5

# 3 2.69

# 4 2.8

# 5 2.62

# 6 2.12

# 7 3.15

# 8 2.97

# 9 3.1

# 10 3.02

# # ... with 133 more rowsUtilizando a função summarise() é possível criar uma ou mais variáveis escalares resumindo as variáveis de um tibble existente. Como resultado, uma linha é retornada. O seguinte código calcula a média global da MGRA e retorna o n utilizado na estimativa.

maize %>%

summarise(MGRA_mean = mean(MGRA),

n = n())

# # A tibble: 1 x 2

# MGRA_mean n

# <dbl> <int>

# 1 173. 780Muitas vezes é necessário computar uma determinada função (como a média) para cada nível de uma variável categórica. Felizmente, o pacote dplyr possibilita que isto seja realizado facilmente. Continuamos no mesmo exemplo anterior. Neste caso, no entanto, o objetivo é calcular a média da MGRA para cada híbrido. Utilizando a função group_by() antes da função summarise() uma linha de resultado para cada nível do fator híbrido é retornado.

maize %>%

group_by(HIB) %>%

summarise(MGRA_mean = mean(MGRA),

n = n())

# # A tibble: 13 x 3

# HIB MGRA_mean n

# * <chr> <dbl> <int>

# 1 H1 184. 60

# 2 H10 164. 60

# 3 H11 167. 60

# 4 H12 157. 60

# 5 H13 180. 60

# 6 H2 187. 60

# 7 H3 169. 60

# 8 H4 184. 60

# 9 H5 184. 60

# 10 H6 188. 60

# 11 H7 171. 60

# 12 H8 160. 60

# 13 H9 153. 60Até aqui vimos como a média (global ou para cada híbrido) da MGRA pode ser calculada. Quase sempre, no entanto, quando calculamos a média (ou qualquer outra medida) em um conjunto de dados, queremos fazê-la para todas (ou algumas) variáveis numéricas dos dados. Implementar isto com dplyr é relativamente fácil. Para isto, é utilizada a função across() que aplica uma função (ou um conjunto de funções) a um conjunto de colunas.

Veremos como across() pode ser utilizada para calcular a média para as variáveis numéricas do conjunto maize. No exemplo abaixo, where() aplica uma função (neste caso is.numeric()) a todas as variáveis e seleciona aquelas para as quais a função retorna TRUE. Assim, a média somente é calculada para as variáveis numéricas.

maize %>%

summarise(across(where(is.numeric), mean))

# # A tibble: 1 x 7

# APLA AIES CESP DIES MGRA MMG NGRA

# <dbl> <dbl> <dbl> <dbl> <dbl> <dbl> <dbl>

# 1 2.48 1.34 15.2 49.5 173. 339. 512.Funções próprias podem ser aplicadas dentro da função summarise() para computar uma estatística personalizada. Como exemplo, vamos criar uma função chamada mse que retornará o valor da média e o erro padrão da média e aplicá-la a todas as variáveis que iniciam "M", para cada nível do fator AMB.

mse <- function(x){

me = round(mean(x), 3)

se = round(sd(x)/sqrt(n()), 3)

return(paste0(me, "+-", se))

}

maize %>%

group_by(AMB) %>%

summarise(across(starts_with("M"), mse))

# # A tibble: 4 x 3

# AMB MGRA MMG

# * <chr> <chr> <chr>

# 1 A1 199.437+-3.232 360.337+-4.164

# 2 A2 168.436+-3.381 333.815+-4.86

# 3 A3 146.811+-2.787 317.718+-4.421

# 4 A4 177.072+-3.118 342.796+-4.195Se desejamos computar mais de uma função para variáveis específicas, então o próximo código nos ajudará. Note que para aplicar mais de uma função é necessário criar uma lista ou vetor com o nome das funções. Neste caso, os sufixos _m e _sd representam a média e o desvio padrão, respectivamente.

maize %>%

group_by(AMB) %>%

summarise(across(starts_with("M"), list(m = mean, sd = sd)))

# # A tibble: 4 x 5

# AMB MGRA_m MGRA_sd MMG_m MMG_sd

# * <chr> <dbl> <dbl> <dbl> <dbl>

# 1 A1 199. 45.1 360. 58.1

# 2 A2 168. 47.2 334. 67.9

# 3 A3 147. 38.9 318. 61.7

# 4 A4 177. 43.5 343. 58.6Variáveis categóricas podem ser criadas utilizando a função case_when() . case_when() é particularmente útil dentro da função mutate() quando você quer criar uma nova variável que depende de uma combinação complexa de variáveis existentes. No exemplo abaixo, uma nova variável será criada, dependendo dos valores de APLA, AIES ou CESP

maize %>%

mutate(

CASE = case_when(

MGRA > 280 | APLA < 1.3 | NGRA > 820 ~ "Selecionar",

APLA > 2.3 ~ "Alto",

MGRA < 130 ~ "Pouco produtivo",

TRUE ~ "Outro"

)

) %>%

select_non_numeric_cols()

# # A tibble: 780 x 4

# AMB HIB REP CASE

# <chr> <chr> <chr> <chr>

# 1 A1 H1 I Alto

# 2 A1 H1 I Alto

# 3 A1 H1 I Alto

# 4 A1 H1 I Alto

# 5 A1 H1 I Alto

# 6 A1 H1 II Outro

# 7 A1 H1 II Alto

# 8 A1 H1 II Alto

# 9 A1 H1 II Alto

# 10 A1 H1 II Alto

# # ... with 770 more rows10.1.4 Estatística descritiva com pacote metan

O pacote metan fornece uma estrutura simples e intuitiva para o cálculo de estatísticas descritivas. Um conjunto de funções pode ser usado para calcular rapidamente as estatísticas descritivas mais usadas.

Para calcular os valores médios para cada nível de um fator, por exemplo para cada nível do fator HIB do conjunto de dados maize, usamos a funçãomeans_by().

means_by(maize, HIB)

# # A tibble: 13 x 8

# HIB APLA AIES CESP DIES MGRA MMG NGRA

# * <chr> <dbl> <dbl> <dbl> <dbl> <dbl> <dbl> <dbl>

# 1 H1 2.62 1.50 15.1 51.2 184. 365. 507.

# 2 H10 2.31 1.26 15.1 48.4 164. 320. 504.

# 3 H11 2.39 1.27 15.2 48.8 167. 333. 501.

# 4 H12 2.44 1.28 14.3 48.6 157. 316. 502.

# 5 H13 2.54 1.35 15.0 50.6 180. 340. 538.

# 6 H2 2.60 1.38 15.3 50.9 187. 356. 527.

# 7 H3 2.59 1.41 14.5 49.4 169. 346. 491.

# 8 H4 2.58 1.43 15.7 49.2 184. 346. 535.

# 9 H5 2.57 1.37 15.6 49.9 184. 341. 542.

# 10 H6 2.56 1.41 15.8 51.5 188. 363. 516.

# 11 H7 2.40 1.32 15.4 49.5 171. 345. 498.

# 12 H8 2.33 1.21 15.0 48.4 160. 322. 496.

# 13 H9 2.36 1.27 15.0 47.6 153. 311. 496.As seguintes funções _by() estão disponíveis para calcular as principais estatísticas descritivas por níveis de um fator.

-

cv_by ()Para cálculo do coeficiente de variação. -

max_by ()Para calcular valores máximos. -

means_by ()Para calcular meios aritméticos. -

min_by ()Para compilar valores mínimos. -

n_by ()Para obter o comprimento. -

sd_by ()Para calcular o desvio padrão amostral. -

sem_by ()Para calcular o erro padrão da média.

10.1.4.1 Funções úteis

Outras funções úteis também são implementadas. Todos eles funcionam naturalmente com %>%, lidam com dados agrupados com group_by() e várias variáveis (todas as variáveis numéricas de .data por padrão).

-

av_dev ()calcula o desvio médio absoluto. -

ci_mean ()calcula o intervalo de confiança para a média. -

cv ()calcula o coeficiente de variação. -

freq_table ()Calcula a fábula de frequência. -

hm_mean (),gm_mean ()calcula as médias harmônica e geométrica, respectivamente. A média harmônica é o recíproco da média aritmética dos recíprocos. A média geométrica é a enésima raiz de n produtos. -

kurt ()calcula a curtose como usada no SAS e no SPSS. -

range_data ()Calcula o intervalo dos valores. -

sd_amo (),sd_pop ()Calcula amostra e desvio padrão populacional, respectivamente. -

sem ()calcula o erro padrão da média. -

skew ()calcula a assimetria usada no SAS e no SPSS. -

sum_dev ()calcula a soma dos desvios absolutos. -

sum_sq_dev ()calcula a soma dos desvios ao quadrado. -

var_amo (),var_pop ()calcula amostra e variação populacional. -

valid_n ()Retorna o comprimento válido (não NA) de um dado.

10.1.4.2 A função desc_stat()

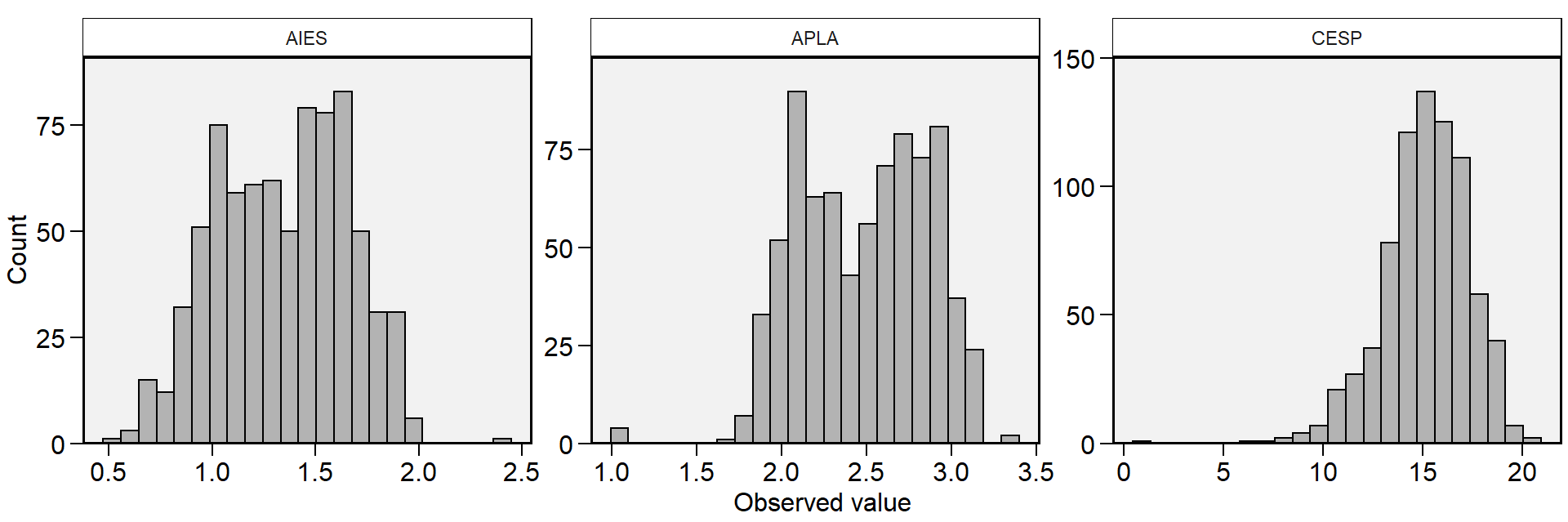

Para calcular todas as estatísticas de uma só vez, podemos usar desc_stat(). Esta função pode ser usada para calcular medidas de tendência central, posição e dispersão. Por padrão (stats = "main"), sete estatísticas (coeficiente de variação, máximo, média, mediana, mínimo, desvio padrão da amostra, erro padrão e intervalo de confiança da média) são calculadas. Outros valores permitidos são "all" para mostrar todas as estatísticas, "robust" para mostrar estatísticas robustas, "quantile" para mostrar estatísticas quantílicas ou escolher uma (ou mais) estatísticas usando um vetor separado por vírgula com os nomes das estatísticas, por exemplo, stats = c("mean, cv"). Também podemos usar hist = TRUE para criar um histograma para cada variável. Aqui, auxiliares selecionados também podem ser usados no argumento ....

- Todas as estatísticas para todas as variáveis numéricas

desc_stat(maize, stats = "all")

# # A tibble: 7 x 32

# variable av.dev ci cv gmean hmean iqr kurt mad max

# <chr> <dbl> <dbl> <dbl> <dbl> <dbl> <dbl> <dbl> <dbl> <dbl>

# 1 AIES 0.268 0.0221 23.4 1.30 1.26 0.502 -0.729 0.363 2.39

# 2 APLA 0.322 0.0264 15.1 2.45 2.42 0.64 -0.292 0.474 3.3

# 3 CESP 1.65 0.152 14.3 15.0 14.5 2.6 2.83 1.93 20.4

# 4 DIES 3.02 0.260 7.46 49.4 49.3 5.29 -0.285 3.82 59.7

# 5 MGRA 39.0 3.35 27.5 166. 157. 69.0 -0.56 51.0 291.

# 6 MMG 51.5 4.46 18.7 332. 325. 87.8 -0.0484 66.2 546.

# 7 NGRA 88.4 7.98 22.2 498. 482. 148. 0.321 110. 903

# # ... with 22 more variables: mean <dbl>, median <dbl>, min <dbl>, n <dbl>,

# # n.valid <dbl>, n.missing <dbl>, n.unique <dbl>, ps <dbl>, q2.5 <dbl>,

# # q25 <dbl>, q75 <dbl>, q97.5 <dbl>, range <dbl>, sd.amo <dbl>, sd.pop <dbl>,

# # se <dbl>, skew <dbl>, sum <dbl>, sum.dev <dbl>, sum.sq.dev <dbl>,

# # var.amo <dbl>, var.pop <dbl>- Estatísticas robustas usando select helpers

maize %>%

desc_stat(contains("N"),

stats = "robust")

# # A tibble: 1 x 5

# variable n median iqr ps

# <chr> <dbl> <dbl> <dbl> <dbl>

# 1 NGRA 780 517 148. 110.- Funções quantílicas escolhendo nomes de variáveis

maize %>%

desc_stat(APLA, AIES, CESP,

stats = "quantile")

# # A tibble: 3 x 7

# variable n min q25 median q75 max

# <chr> <dbl> <dbl> <dbl> <dbl> <dbl> <dbl>

# 1 AIES 780 0.5 1.09 1.38 1.59 2.39

# 2 APLA 780 1 2.16 2.52 2.8 3.3

# 3 CESP 780 0.8 14 15.4 16.6 20.4- Crie um histograma para cada variável

# # A tibble: 3 x 9

# variable cv max mean median min sd.amo se ci

# <chr> <dbl> <dbl> <dbl> <dbl> <dbl> <dbl> <dbl> <dbl>

# 1 AIES 23.4 2.39 1.34 1.38 0.5 0.314 0.0113 0.0221

# 2 APLA 15.1 3.3 2.48 2.52 1 0.375 0.0134 0.0264

# 3 CESP 14.3 20.4 15.2 15.4 0.8 2.16 0.0774 0.15210.1.4.3 Estatísticas por níveis de fatores

Para calcular as estatísticas para cada nível de um fator, use o argumento by. Além disso, é possível selecionar as estatísticas a serem computadas usando o argumento stats, que é um único nome estatístico, por exemplo,"mean"ou um vetor de nomes separados por vírgula com " no início e apenas o final do vetor. Tenha em atenção que os nomes das estatísticas NÃO diferenciam maiúsculas de minúsculas, por exemplo, são reconhecidos "mean", "Mean" ou "MEAN". Vírgula ou espaços podem ser usados para separar os nomes das estatísticas.

-

Todas as opções abaixo funcionarão:

stats = c ("mean, se, cv, max, min")stats = c ("mean se cv max min")stats = c ("MEAN, Se, CV max MIN")

desc_stat (maize,

contains("C"),

stats = ("mean, se, cv, max, min"),

by = AMB)

# # A tibble: 4 x 7

# AMB variable mean se cv max min

# <chr> <chr> <dbl> <dbl> <dbl> <dbl> <dbl>

# 1 A1 CESP 15.6 0.171 15.3 20.3 0.8

# 2 A2 CESP 15.2 0.148 13.6 19.2 8.7

# 3 A3 CESP 14.7 0.145 13.8 19.9 7.5

# 4 A4 CESP 15.1 0.148 13.7 20.4 8.2Para calcular as estatísticas descritivas por mais de uma variável de agrupamento, precisamos passar dados agrupados para o argumento .data com a funçãogroup_by(). Vamos calcular a média, o erro padrão da média e o tamanho da amostra para as variáveis EP eEL para todas as combinações dos fatores AMB eHIB.

stats <-

maize %>%

group_by(AMB, HIB) %>%

desc_stat(APLA, AIES, CESP,

stats = c("mean, se, n"))

stats

# # A tibble: 156 x 6

# AMB HIB variable mean se n

# <chr> <chr> <chr> <dbl> <dbl> <dbl>

# 1 A1 H1 AIES 1.68 0.0599 15

# 2 A1 H1 APLA 2.72 0.0695 15

# 3 A1 H1 CESP 15.4 0.451 15

# 4 A1 H10 AIES 1.62 0.0506 15

# 5 A1 H10 APLA 2.78 0.0716 15

# 6 A1 H10 CESP 16.1 0.662 15

# 7 A1 H11 AIES 1.58 0.0302 15

# 8 A1 H11 APLA 2.75 0.0236 15

# 9 A1 H11 CESP 16.6 0.332 15

# 10 A1 H12 AIES 1.54 0.0456 15

# # ... with 146 more rowsQuando as estatísticas são calculadas para níveis de um fator, a função desc_wider() pode ser utilizada para converter uma estatística calculada em um conjunto de dados em formato wide, ou seja, variáveis nas colunas, fatores nas linhas com o valor da estatística escolhida preenchendo a tabela.

desc_wider(stats, se)

# # A tibble: 52 x 5

# AMB HIB AIES APLA CESP

# <chr> <chr> <dbl> <dbl> <dbl>

# 1 A1 H1 0.0599 0.0695 0.451

# 2 A1 H10 0.0506 0.0716 0.662

# 3 A1 H11 0.0302 0.0236 0.332

# 4 A1 H12 0.0456 0.0582 0.498

# 5 A1 H13 0.0562 0.05 0.295

# 6 A1 H2 0.0327 0.0507 0.637

# 7 A1 H3 0.0383 0.0323 0.543

# 8 A1 H4 0.0448 0.043 0.437

# 9 A1 H5 0.0315 0.0442 0.618

# 10 A1 H6 0.0447 0.0704 0.347

# # ... with 42 more rows10.1.5 Testes de aderência

Testes de aderência a distribuições teóricas também são de grande utilizada para as ciências agrárias. O teste de Shapiro-Wilk, realizado pela função shapiro.test() , é amplamente utilizada para realizar o teste de normalidade dos dados. Para testar a aderência a outras distribuições teóricas, o teste de Kolmolgorov-Smirnov (função ks.test()) é uma alternativa.

# Teste de Shapiro-Wilk

shapiro.test(Amostra1)

#

# Shapiro-Wilk normality test

#

# data: Amostra1

# W = 0.9956, p-value = 0.9876

shapiro.test(Amostra2)

#

# Shapiro-Wilk normality test

#

# data: Amostra2

# W = 0.95815, p-value = 0.002976

# Kolmogorov–Smirnov

# Amostra1 e Amostra2 provém da mesma distribuição?

ks.test(Amostra1, Amostra2)

#

# Two-sample Kolmogorov-Smirnov test

#

# data: Amostra1 and Amostra2

# D = 0.29, p-value = 0.0004453

# alternative hypothesis: two-sided

# Amostra1 ~ N(12, 3)?

ks.test(Amostra1, "pnorm", 12, 3)

#

# One-sample Kolmogorov-Smirnov test

#

# data: Amostra1

# D = 0.094659, p-value = 0.3317

# alternative hypothesis: two-sided10.1.6 Intervalos de confiança

A estimação por intervalo não fornece idéia da margem de erro cometida ao estimar um determinado parâmetro (Ferreira 2009). Por isso, para verificar se uma dada hipótese \(H_0\) (de igualdade) é ou não verdadeira, deve-se utilizar intervalos de confiança ou testes de hipóteses. A construção destes intervalos, e as particularidades dos testes de hipóteses, serão discutidos a seguir. Recomendamos como literatura o livro Estatística Básica30 escrito pelo Prof. Daniel Furtado Ferreira da UFV. Para verificar a normalidade dos dados, as funções shapiro.test() e ks.test() e os gráficos QQ-Plot são de grande utilidade.

Será demostrado como testar hióteses para uma e duas médias pelo teste t de Student, o que exiege que os dados tenham distribuição normal univariada (já discutido anteriormente) ou bivariada (dados emparelhados). Para testar a normalidade bivariada, basta testar a normalidade da diferença entre as variáveis:

Amostra3 <- Amostra1 - Amostra2

shapiro.test(Amostra3)

#

# Shapiro-Wilk normality test

#

# data: Amostra3

# W = 0.97923, p-value = 0.1158A partir de um intervalo que tenha alta probabilidade de conter o valor paramétrico, é possível diferenciar duas estimativas (Ferreira 2009). O intervalo de confiança de uma média amostral de 95% é dado por:

\[ P\left[ {\bar X - {t_{\alpha /2}}\frac{S}{{\sqrt n }} \le \mu \le \bar X + {t_{\alpha /2}}\frac{S}{{\sqrt n }}} \right] = 1 - \alpha \]

Na expressão acima, \(\bar X\) é a média, \(S\) é o desvio padrão e \(-t_{\alpha /2}\) e \(+t_{\alpha /2}\) são os quantis inferior e superior, respectivamente, da distribuição t de Student. O intervalo acima indica que o valor do parâmetro (\(\mu\)) tem 95% de chance de estar contido no intervalo. Ressalta-se que a expressão acima está relacionada com a precisão e não com a acurácia da estimativa. Para calcular esse intervalo, podemos utilizar a função t.teste() .

result <- t.test(Amostra1)

result$conf.int # Intervalo de confiança

# [1] 11.79200 12.86133

# attr(,"conf.level")

# [1] 0.95

result$estimate # média

# mean of x

# 12.32666O intervalo de confiança é, por default, de 95%. Poém, pode-se modificar através do argumento conf.level.

result <- t.test(Amostra1, conf.level = 0.99)

result1 <- t.test(Amostra1, conf.level = 0.90)

result$conf.int # Intervalo de confiança

# [1] 11.61895 13.03437

# attr(,"conf.level")

# [1] 0.99

result1$conf.int # Intervalo de confiança

# [1] 11.87925 12.77407

# attr(,"conf.level")

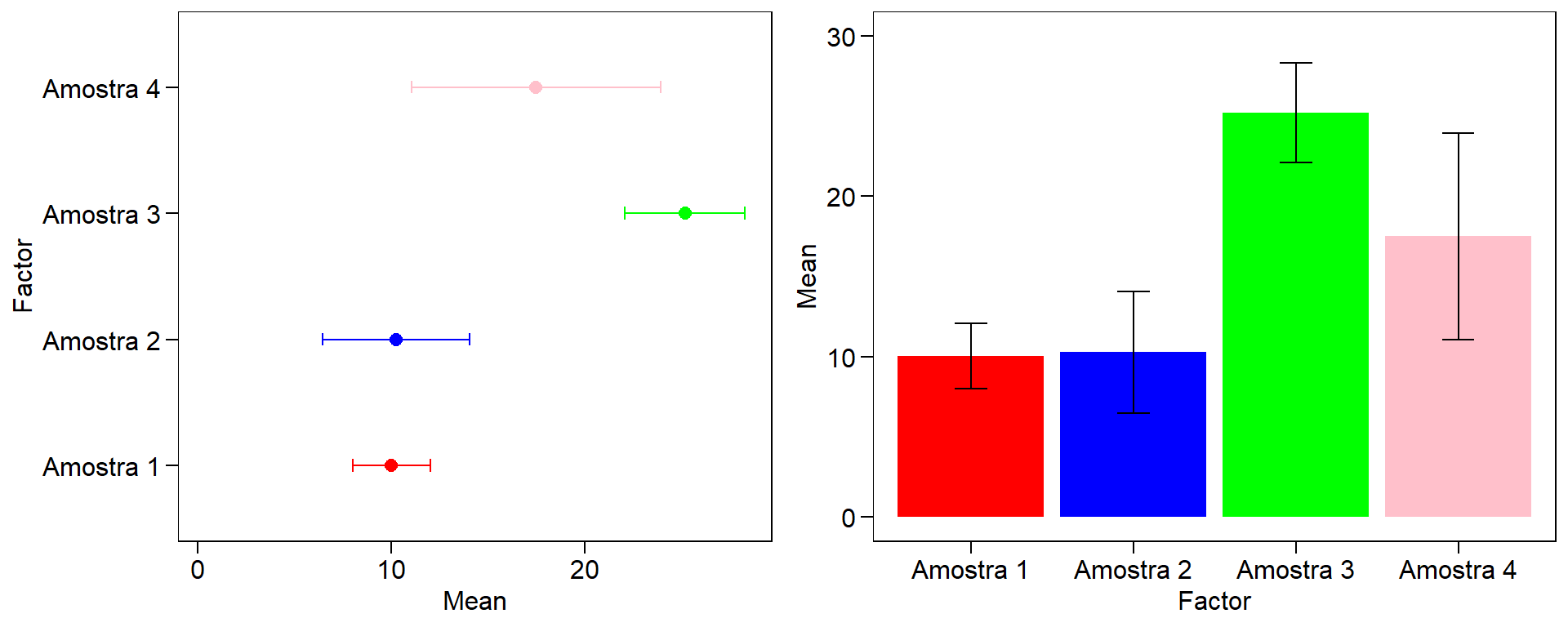

# [1] 0.9Para gerar os gráficos de intervalo de confiança será utilizada a função ggplot() do pacote ggplot2.

set.seed(100) #Ajusta a semente para reprodução dos números

Amostra1 <- rnorm(100,10,10)

Amostra2 <- rnorm(100,10,24)

Amostra3 <- rnorm(100,25,15)

Amostra4 <- rnorm(100,20,30)

dados_IC <- tibble(

Factor = c("Amostra 1","Amostra 2", "Amostra 3", "Amostra 4"),

LL = c(t.test(Amostra1)$conf.int[1],

t.test(Amostra2)$conf.int[1],

t.test(Amostra3)$conf.int[1],

t.test(Amostra4)$conf.int[1]),

Mean = c(t.test(Amostra1)$estimate,

t.test(Amostra2)$estimate,

t.test(Amostra3)$estimate,

t.test(Amostra4)$estimate),

UL = c(t.test(Amostra1)$conf.int[2],

t.test(Amostra2)$conf.int[2],

t.test(Amostra3)$conf.int[2],

t.test(Amostra4)$conf.int[2]))

# Gráfico com barras de erros

cbPalette = c("red", "blue", "green", "pink") # armazenando as cores

err1 = ggplot(data = dados_IC, aes(y = Mean, x = Factor, colour = Factor)) +

geom_point(size = 2.5)+ # adiciona um ponto ao gráfico

geom_errorbar(aes(ymax = UL, ymin = LL), width = 0.1)+

scale_color_manual(values = cbPalette)+

coord_flip()+ # "inverte" o "x" e o "y"

expand_limits(y = c(0.4,0.6))+

theme(legend.position = "none")

# Gráfico de barras com barras de erros

err2 = ggplot(data = dados_IC, aes(y = Mean, x = Factor)) +

geom_bar(aes(fill = Factor), stat = "identity", position = "dodge")+

geom_errorbar(aes( ymax = UL, ymin = LL), width = 0.2)+

expand_limits(y = c(0,30)) +

scale_fill_manual(values = cbPalette)+

theme(legend.position = "none")

plot_grid(err1, err2)

Figure 10.1: Gráficos de intervalo de confiança (mais de uma variável)

10.1.7 Teste de hipóteses para amostras independentes

Os testes de hipóteses aqui demonstrados tem como objetivo (i) verificar se determianda amostra difrere ou não de zero (\({H_0}:\mu = 0\)) e (ii) se duas amostras são ou não iguais (\({H_0}:{\mu _1} = {\mu _2}\)). Para testar as hipóteses pode-se utilizar a função t.teste(). Utilizaremos como amostras os dados da variável MGRA do conjunto maize. A primeira amostra corresponde contém os valores de A1 e a segunda os valores de A2

Amostra1 <- maize %>% filter(AMB == "A1") %>% select(MGRA) %>% pull()

Amostra2 <- maize %>% filter(AMB == "A2") %>% select(MGRA) %>% pull()

t.test(Amostra1) # testa se a amostra difere de zero

#

# One Sample t-test

#

# data: Amostra1

# t = 61.71, df = 194, p-value < 2.2e-16

# alternative hypothesis: true mean is not equal to 0

# 95 percent confidence interval:

# 193.0630 205.8111

# sample estimates:

# mean of x

# 199.437

t.test(Amostra1, Amostra2) # testa se as amostras difrem entre si

#

# Welch Two Sample t-test

#

# data: Amostra1 and Amostra2

# t = 6.6279, df = 387.21, p-value = 1.144e-10

# alternative hypothesis: true difference in means is not equal to 0

# 95 percent confidence interval:

# 21.80515 40.19763

# sample estimates:

# mean of x mean of y

# 199.4370 168.4356Alternativamente, o pacote ggstatplot31 pode ser utilizado para confecionar gráficos que incluem teste de hipóteses.

O teste t pode ser utilizado para testar tanto hipóteses do tipo \({H_A}:\mu > 0\) ou \({H_A}:\mu < 0\). Porém, para isso, devemos utilizar o argumento alternative para indicar que o teste utilizado é unilateral.

t.test(Amostra1, alternative = "greater") # unilateral a direita

#

# One Sample t-test

#

# data: Amostra1

# t = 61.71, df = 194, p-value < 2.2e-16

# alternative hypothesis: true mean is greater than 0

# 95 percent confidence interval:

# 194.0956 Inf

# sample estimates:

# mean of x

# 199.437

t.test(Amostra1, alternative = "less") # unilateral a esquerda

#

# One Sample t-test

#

# data: Amostra1

# t = 61.71, df = 194, p-value = 1

# alternative hypothesis: true mean is less than 0

# 95 percent confidence interval:

# -Inf 204.7784

# sample estimates:

# mean of x

# 199.437Outro pressuposto para realizar o teste t é a homogeneidade das variâncias. Quando as variâncias são heterogêneas, o grau de liberdade utilizado é calculado pela aproximação de Welch-Satterthwaite:

\[ \nu \cong \frac{{{{\left( {\frac{{S_1^2}}{{{n_1}}} + \frac{{S_2^2}}{{{n_2}}}} \right)}^2}}}{{\frac{{{{\left( {\frac{{S_1^2}}{{{n_1}}}} \right)}^2}}}{{{n_1} - 1}} + \frac{{{{\left( {\frac{{S_2^2}}{{{n_2}}}} \right)}^2}}}{{{n_2} - 1}}}} \]

var.test(Amostra1, Amostra2) # Teste F para variâncias

#

# F test to compare two variances

#

# data: Amostra1 and Amostra2

# F = 0.91355, num df = 194, denom df = 194, p-value = 0.5295

# alternative hypothesis: true ratio of variances is not equal to 1

# 95 percent confidence interval:

# 0.688888 1.211488

# sample estimates:

# ratio of variances

# 0.9135534

t.test(Amostra1, Amostra2, var.equal = FALSE) # Por default, usa Welch-Satterthwaite

#

# Welch Two Sample t-test

#

# data: Amostra1 and Amostra2

# t = 6.6279, df = 387.21, p-value = 1.144e-10

# alternative hypothesis: true difference in means is not equal to 0

# 95 percent confidence interval:

# 21.80515 40.19763

# sample estimates:

# mean of x mean of y

# 199.4370 168.4356

Amostra3 <- rnorm(30, 10, 5)

Amostra4 <- rnorm(30, 18, 5)

var.test(Amostra3, Amostra4)

#

# F test to compare two variances

#

# data: Amostra3 and Amostra4

# F = 0.65152, num df = 29, denom df = 29, p-value = 0.2545

# alternative hypothesis: true ratio of variances is not equal to 1

# 95 percent confidence interval:

# 0.3101021 1.3688474

# sample estimates:

# ratio of variances

# 0.6515231

t.test(Amostra1, Amostra2, var.equal = TRUE) # Quando variâncias são iguais

#

# Two Sample t-test

#

# data: Amostra1 and Amostra2

# t = 6.6279, df = 388, p-value = 1.142e-10

# alternative hypothesis: true difference in means is not equal to 0

# 95 percent confidence interval:

# 21.80520 40.19757

# sample estimates:

# mean of x mean of y

# 199.4370 168.435610.1.8 Teste de hipóteses para amostras dependentes

As formas de comparação discutidas acima consideram as amostras como sendo independentes entre si. Para dados emparelhados, deve-se utiliza o argumento paired = TRUE.

Amostra1 <- rnorm(30,10,5)

Amostra2 <- rnorm(30,15,5)

var.test(Amostra1, Amostra2) # Teste F para variâncias

#

# F test to compare two variances

#

# data: Amostra1 and Amostra2

# F = 0.74981, num df = 29, denom df = 29, p-value = 0.4429

# alternative hypothesis: true ratio of variances is not equal to 1

# 95 percent confidence interval:

# 0.3568811 1.5753388

# sample estimates:

# ratio of variances

# 0.7498058

t.test(Amostra1, Amostra2, var.equal = TRUE) # Independentes

#

# Two Sample t-test

#

# data: Amostra1 and Amostra2

# t = -3.2434, df = 58, p-value = 0.001961

# alternative hypothesis: true difference in means is not equal to 0

# 95 percent confidence interval:

# -7.208743 -1.706572

# sample estimates:

# mean of x mean of y

# 9.873579 14.331237

t.test(Amostra1, Amostra2, var.equal = TRUE, paired = TRUE) # Emparelhadas

#

# Paired t-test

#

# data: Amostra1 and Amostra2

# t = -3.6981, df = 29, p-value = 0.000902

# alternative hypothesis: true difference in means is not equal to 0

# 95 percent confidence interval:

# -6.922951 -1.992364

# sample estimates:

# mean of the differences

# -4.457658Observa-se que existe uma diferença no valor da estatistica teste, nos graus de liberdade, no valor tabelado e, consequentemente, no p-valor. Para duas amostras independentes, o teste para a diferença é dado por

\[ {t_c} = \frac{{{{\bar X}_1} - {{\bar X}_2}}}{{S\sqrt {\frac{1}{{{n_1}}} + \frac{1}{{{n_2}}}} }} \sim {t_{\left( {\alpha ,\nu } \right)}} \]

Onde \(\alpha\) é a probabilidade de erro, \(\nu\) é o grau de liberdade (nº total de obervações-2), \(S\) é a média ponderada do desvio padrão, \({\bar X}_1\) e \({\bar X}_2\) são a média das amostras 1 e 2, respectivamente, e \(n_1\) e \(n_1\) e \(n_2\) são os tamanhos de amostra da amostra 1 e 2, respectivamente. No resultado acima, obervamos que \(\nu = 58\).

No caso de amostras pareadas (dependentes), a estatística teste é dada por

\[ {t_c} = \frac{{\bar d - {\mu _0}}}{{\frac{{{S_d}}}{{\sqrt n }}}} \sim {t_{\left( {\alpha ,\nu } \right)}} \]

Onde \(\alpha\) é a probabilidade de erro, \(\nu\) é o grau de liberdade (nº de diferenças-1), \(\bar d\) é a média das diferenças, \(S_d\) é o desvio padrão das diferenças e \(n\) é o número de diferenças. No resultado acima,obervamos que \(\nu = 29\).

10.2 Delineamentos básicos

As análises realizadas até agora tinham como objetivo verificar a existência de diferenças entre as médias de duas amostras. Porém, quando deseja-se estudar o efeito de “grupos de fatores” sobre determinado fenômeno, a análise da variância (ANOVA) é indicada. A ANOVA atribui a diversos fatores partes da variabilidade dos dados (Casella 2008).

Os delineamentos experimentais também são parte importante da ANOVA. Será dado mais destaque aos mais comuns: o delineamento inteiramente casualisado (DIC) e o blocos ao acaso (DBC) . O bloqueamento tem como objetivo remover parte da variabilidade. Como não se deseja encotrar diferença entre os blocos, análises complementares não são realizadas para este fator.

Nessa seção será demostrado como analisar dados experimentais utilizando estes dois delineamentos. Em um primeiro momento, serão demonstrados experimentos unifatorias e, posteriormente, experimentos bifatoriais com e sem parcelas subdivididas. Formas de como verificar se os pressupostos do modelo estatistico estão sendo cumpridos, e formas de contornar este problema caso estejam sendo violados, também serão demonstrados. Por fim, após a análise da variância, serão mostrados os testes complementares utilizados para tratamentos quali e quantitativos.

10.2.1 Princípios básicos

Os principios básicos da experimentação são a casualisação e a repetição. A repetição possibilita que o erro seja estimado, e a casualisação que eles sejam independentes.

10.2.2 Pressupostos

Independente do delineamento, os pressupostos do modelo estatístico são que os erros são independentes, homocedásticos e normais:

\[ {\boldsymbol{\varepsilon }} \sim {\textrm N}\left( {0,{\boldsymbol{I}}{\sigma ^2}} \right) \]

As formas de realizar esse diagnóstico é através de testes estatísticos e gráficos de diagnósticos. Uma ferramente para contornar o problema de violação dos pressupostos é a transformação dos dados. Existem várias formas de transformar os dados (cada uma adequada a um caso específico), mas será dado enfase à transformação Box-Cox.

10.2.3 Estimação

A estimativa dos parâmetros é realizado pelo método dos minimos quadrados. Devido a matriz delineamento ser de posto incompleto (modelo superparametrizado), uma restrição deve ser imposta ao fator tratamentos para que a estimativa do efeito dos fatores seja única (\(\sum {{t_i}} = 0\)). Reparametrizações ou combinações lineares também podem ser utilizados para garantir a unicidade dos parâmetros (Rencher and Schaalje 2008).

10.2.4 Reparametrização, condições marginais ou combinações lineares?

As funções lm() e aov() são usualmente utilizadas para realizar a análise da variância. Ambas utilizam a reparametrização o modelo para estimar os parâmetros. Vamos ver isso no exemplo abaixo utilizando o conjunto de dados QUALI

url <- "https://github.com/TiagoOlivoto/e-bookr/raw/master/data/data_R.xlsx"

dados <- import(url, sheet = "QUALI")

## Usando a função aov()

mod1 <- aov(RG ~ HIBRIDO, data = dados)

coef(mod1)

# (Intercept) HIBRIDONP_10 HIBRIDONP_2 HIBRIDONP_3 HIBRIDONP_4 HIBRIDONP_5

# 10.27750 -3.99450 -1.44550 -0.79750 -0.79675 -1.52675

# HIBRIDONP_6 HIBRIDONP_7 HIBRIDONP_8 HIBRIDONP_9

# -2.94125 -3.23250 -3.03250 -3.28525

mod2 <- lm(RG ~ HIBRIDO, data = dados)

coef(mod2)

# (Intercept) HIBRIDONP_10 HIBRIDONP_2 HIBRIDONP_3 HIBRIDONP_4 HIBRIDONP_5

# 10.27750 -3.99450 -1.44550 -0.79750 -0.79675 -1.52675

# HIBRIDONP_6 HIBRIDONP_7 HIBRIDONP_8 HIBRIDONP_9

# -2.94125 -3.23250 -3.03250 -3.28525

## Abordagem matricial

y <- as.matrix(dados$RG)

x <- model.matrix(~HIBRIDO, data = dados)

beta <- solve(t(x) %*% x) %*% t(x) %*% y

beta

# [,1]

# (Intercept) 10.27750

# HIBRIDONP_10 -3.99450

# HIBRIDONP_2 -1.44550

# HIBRIDONP_3 -0.79750

# HIBRIDONP_4 -0.79675

# HIBRIDONP_5 -1.52675

# HIBRIDONP_6 -2.94125

# HIBRIDONP_7 -3.23250

# HIBRIDONP_8 -3.03250

# HIBRIDONP_9 -3.28525Abaixo é apresentado o calculo da ANOVA de mod1 através de uma aboragem matricial. Portanto verifica-se que a reparametrização é o método utilizado pelas funções aov() e lm().

# Anova com uma abrodagem matricial

SQtrat <- t(beta) %*% t(x) %*% y - ((sum(y))^2)/40

SQtotal <- t(y) %*% y - ((sum(y))^2)/40

SQres <- SQtotal - SQtrat

Fc <- (SQtrat / 9) / (SQres / 30)

p_val <- pf(Fc, 9, 30, lower.tail = FALSE)

cat("\nSQtrat = ", SQtrat)

#

# SQtrat = 65.66176

cat("\nSQtotal = ", SQtotal)

#

# SQtotal = 171.8282

cat("\nSQres = ", SQres)

#

# SQres = 106.1664

cat("\nFc = ", Fc)

#

# Fc = 2.061599

cat("\np_val = ", p_val, "\n")

#

# p_val = 0.06654502

anova(mod1)

# Analysis of Variance Table

#

# Response: RG

# Df Sum Sq Mean Sq F value Pr(>F)

# HIBRIDO 9 65.662 7.2958 2.0616 0.06655 .

# Residuals 30 106.166 3.5389

# ---

# Signif. codes: 0 '***' 0.001 '**' 0.01 '*' 0.05 '.' 0.1 ' ' 1Demonstrar como o procedimento de estimação e cálculo da ANOVA serviu apenas para verificar de maneira didática como as funções no R contornam o problema da singularidade da matriz delineamento. Conforme já relatado acima, as funções aov() e lm() podem ser utilizadas para realizar a ANOVA. Porém, nesta seção será dado enfase as funções do pacote ExpDes.pt, cujas funções possibilitam analisar dados uni e bifatoriais; este último com e sem parcelas subdivididas.

10.2.5 Delineamento inteiramente casualizado (DIC)

10.2.5.1 Modelo estatístico

O delineamento inteiramente casualizado (DIC) é um delineamento adequado para áreas uniformes (parcelas são uniformes), onde não há necessidade de controle local (bloqueamento). Neste delineamento, os tratamentos devem ser distribuidos aleatoriamente nas parcelas.

O modelo do DIC é dado por

\[ {Y_{ij}} = m + {t_i} + {\varepsilon _{ij}} \]

Onde \(m\) é a média geral do experimento, \(t_i\) é o efeito de tratamentos, sendo estimado por \(\hat t_i = \bar Y_{i.} - \bar Y_{..}\) com a seguinte restrição: \(\sum_i \hat t_i = 0 ~~~~\forall_i\) (leia-se, o somatório dos efeitos de tratamento é zero para todo tratamento i). \(\epsilon_{ij}\) é o erro experimental estimado por (\(\hat e_{ij} = Y_{ij} - m - \hat t_i\)) onde \({e_{ij}}\sim NID(0,{\sigma ^2})\).

Experimentos em DIC serão analisados utilizando da função dic() do pacote ExpDes.pt. Os argumentos desta função são:

| Argumento | Descrição |

|---|---|

trat |

Objeto contendo os tratamentos |

resp |

Objeto contendo a variável resposta |

quali |

Se TRUE, o tratamento é qualitativo (default) |

mcomp |

Indicar o teste complementar (Tukey é default) |

nl |

Indica se uma regressão deve ser ajustada (FALSE é o default) |

hvar |

Teste de homogeneidade da variância (Bartlett é o default) |

sigT |

Significância da comparação múltipla |

sigF |

Significância do teste F |

Para maiores detalhes, ver o pdf do pacote32 ou ir em ajuda (digitar ?ExpDes.pt no console).

10.2.5.2 DIC com fatores qualitativos

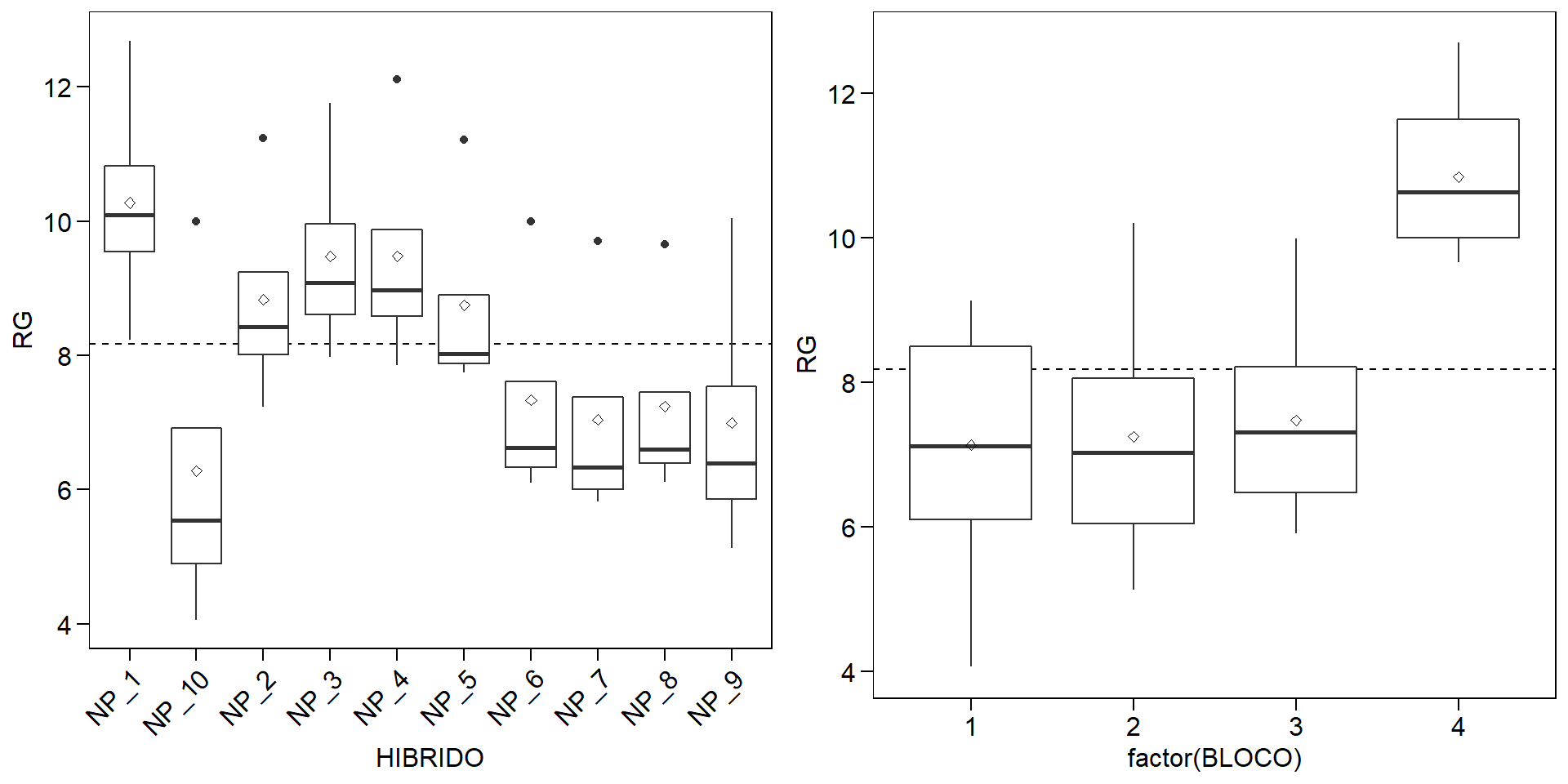

Os dados utilizados neste exemplo estão na planilha QUALI do conjunto de dados data_R.xlsx. Os próximos códigos carregam o conjunto de dados e criam um gráfico do tipo boxplot para explorar o padrão dos dados.

url <- "https://github.com/TiagoOlivoto/e-bookr/raw/master/data/data_R.xlsx"

qualitativo <- import(url, sheet = "QUALI")

p1 <- ggplot(qualitativo, aes(HIBRIDO, RG))+

geom_hline(yintercept = mean(qualitativo$RG), linetype = "dashed")+

geom_boxplot()+

stat_summary(geom = "point", fun = mean, shape = 23)+

theme(axis.text.x = element_text(angle = 45, vjust = 1, hjust = 1))

p2 <- ggplot(qualitativo, aes(factor(BLOCO), RG))+

geom_hline(yintercept = mean(qualitativo$RG), linetype = "dashed")+

geom_boxplot()+

stat_summary(geom = "point", fun = mean, shape = 23)

plot_grid(p1, p2)

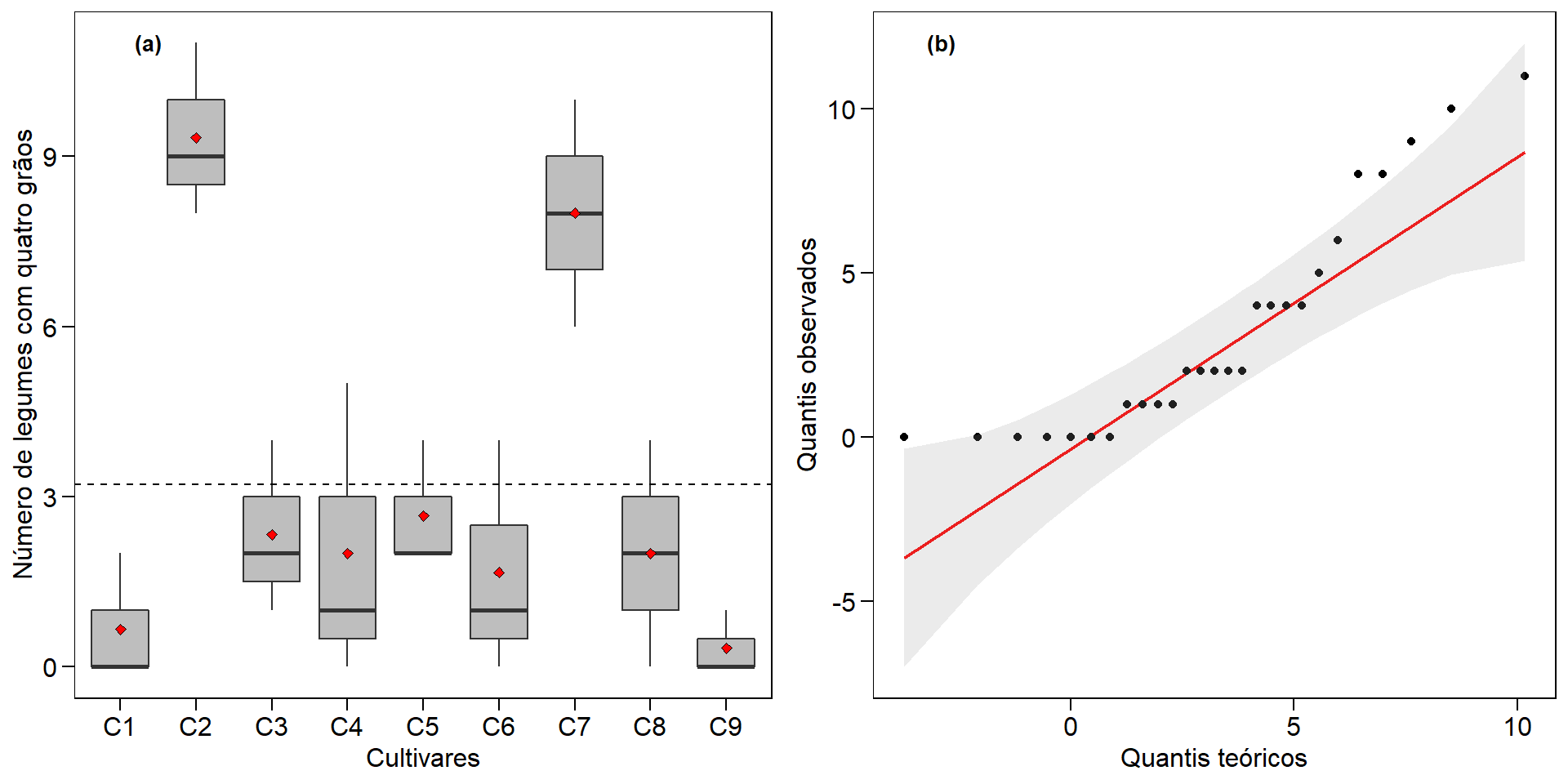

Analizando o boxplot acima é razoável dizer que as médias dos tratamentos são diferentes, principalmente comparando o NUPEC_10 com NUPEC_1. Esta suspeita de diferença, no entanto, deve ser suportada com a realização da análise de variância. No pacote ExpDes.pt, quando os fatores são qualitativos, a análise complementar aplicada é a comparção de médias. A função dic() do pacote retorna a tabela da ANOVA, a análise de pressupostos (normalidade e homogeneidade) e o teste de comparação de médias.

As funções do pacote ExpDes.pt utilizam os dados “anexados” ao ambiente de trabalho, ou seja, um argumento data = . não existe para suas funções. Note que no exemplo abaixo foi utilizado a função with(qualitativo, dic(...)). Isto permite acessar variáveis presentes no data frame. Uma outra maneira de realizar esta mesma análise é utilizando a função attach(qualitativo), qual carregará o data frame no ambiente R, assim é possível utilizar a função dic(...). Após realizada a análise, é recomendado executar o comando detach(qualitativo) para “limpar” os dados do ambiente de trabalho.

mod3 <- with(qualitativo, dic(HIBRIDO, RG))

# ------------------------------------------------------------------------

# Quadro da analise de variancia

# ------------------------------------------------------------------------

# GL SQ QM Fc Pr>Fc

# Tratamento 9 65.662 7.2958 2.0616 0.066545

# Residuo 30 106.166 3.5389

# Total 39 171.828

# ------------------------------------------------------------------------

# CV = 23.02 %

#

# ------------------------------------------------------------------------

# Teste de normalidade dos residuos ( Shapiro-Wilk )

# Valor-p: 3.544449e-05

# ATENCAO: a 5% de significancia, os residuos nao podem ser considerados normais!

# ------------------------------------------------------------------------

#

# ------------------------------------------------------------------------

# Teste de homogeneidade de variancia

# valor-p: 0.0006414681

# ATENCAO: a 5% de significancia, as variancias nao podem ser consideradas homogeneas!

# ------------------------------------------------------------------------

#

# De acordo com o teste F, as medias nao podem ser consideradas diferentes.

# ------------------------------------------------------------------------

# Niveis Medias

# 1 NP_1 10.27750

# 2 NP_10 6.28300

# 3 NP_2 8.83200

# 4 NP_3 9.48000

# 5 NP_4 9.48075

# 6 NP_5 8.75075

# 7 NP_6 7.33625

# 8 NP_7 7.04500

# 9 NP_8 7.24500

# 10 NP_9 6.99225

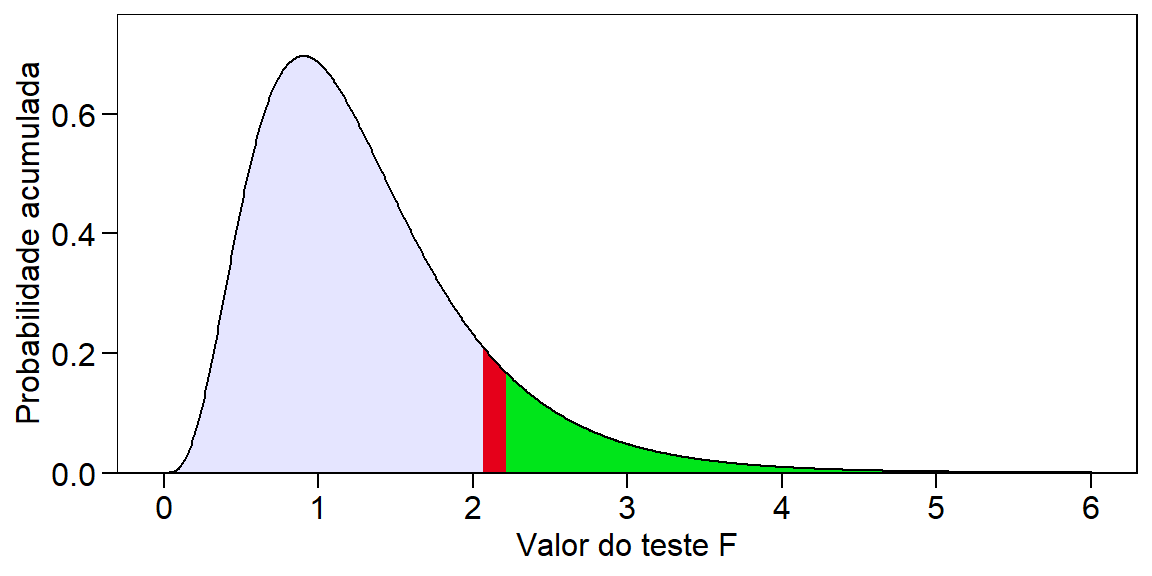

# ------------------------------------------------------------------------A interpretação da significância, ou seja, se as médias de produtividade dos híbridos foram significativamente diferentes a uma determinada probabilidade de erro é feita verificando-se o valor de “Pr>fc” na ANOVA. A figura abaixo mostra a distribuição F considerando os graus de liberdade de tratamento e erro \(F_{9, 30}\) e nos ajuda a compreender um pouco melhor isto. O valor de F calculado em nosso exemplo foi de 2.0616, o que resulta em uma probabilidade de erro acumulada de 0.066545 (6,654%). Na figura abaixo, esta probabilidade de erro acumulada está representada pela cor vermelha. Para que uma diferença significativa a 5% de probabilidade de erro tivesse sido observada, o valor de F calculado deveria ter sido 2.2107 [qf(0.05, 9, 30, lower.tail = FALSE)], representado neste caso pela cor verde no gráfico.

# Warning: `expand_scale()` is deprecated; use `expansion()` instead.

Em sequência a ANOVA, a função retorna o resultado da análise complementar solicitada. Neste exemplo, o teste de Tukey (5% de erro) é utilizado. Este teste realiza todas as combinações possíveis entre as médias (por isso o nome comparação múltipla de medias), comparando se a diferença entre duas médias é maior ou menor que uma diferença mínima significativa (DMS). Esta DMS é calculada pela seguinte fórmula \(DMS = q \times \sqrt{QME/r}\), onde q é um valor tabelado, considerando o número de tratamentos e o GL do erro; QME é o quadrado médio do erro; e r é o número de repetições (ou blocos). O valor de q pode ser encontrado no apêndice 1. Para este caso, considerando 10 e 30 como o número de tratamentos e o GL do erro, respectivamente, o valor de q é 5,76, que aplicado na fórmula resulta em \(DMS = 5,76 \times \sqrt{3.5389/4}=5.417\). Logo, a diferença mínima entre duas médias para que estas sejam significativamente diferentes (5% de erro), deve ser de 5,417 toneladas. Como a diferença entre a maior média (NUPEC_01) e a menor média (NUPEC_10), foi de 3,994 toneladas, a média de todos os tratamentos foram consideradas iguais.

Considerando nosso exemplo, parece razoável dizer que 10,27 t é uma produção maior que 6,28 t. Então, é justo perguntar: O que pode ter acontecido para que as médias não tenham sido consideradas diferentes considerando a probabilidade de erro, mesmo tendo fortes indícios de que elas seriam? A primeira opção que nos vem a mente –e que na maioria das vezes é encontrada em artigos científicos– é que as alterações no rendimento de grão observadas fora resultado do acaso; ou seja, neste caso, há a probabilidade de 6,65% de que uma diferença pelo menos tão grande quanto a observada no estudo possa ser gerada a partir de amostras aleatórias se os tratamentos não aferatem a variável resposta. Logo, a recomendação estatística neste caso, seria por optar por qualquer um dos tratamentos. Do ponto de vista prático, sabemos que esta recomendação está totalmente equivocada. Neste ponto surge uma importante (e polêmica) questão: a interpretação do p-valor. Um p-valor de 0,05 não significa que há uma chance de 95% de que determinada hipótese esteja correta. Em vez disso, significa que se a hipótese nula for verdadeira e todas as outras suposições feitas forem válidas, haverá 5% de chance que diferenças ao menos tão grandes quanto as observadas podem ser obtidas de amostras aleatórias. É preciso ter em mente que o p-valor relatado pelos testes é um significado probabilístico, não biológico. Assim, em experimentos biológicos a interpretação desta estatística deve ser cautelosa, pois um p-valor não pode indicar a importância de uma descoberta. Por exemplo, um medicamento pode ter um efeito estatisticamente significativo nos níveis de glicose no sangue dos pacientes sem ter um efeito terapêutico. Sugerimos a leitura de cinco interessantes artigos relacionados a este assunto (Altman and Krzywinski 2017; Baker 2016; Chawla 2017; Krzywinski and Altman 2013; Nuzzo 2014).

A fórmula da DMS descrita acima é utilizada apenas se (e somente se) o número de repetições de todos os tratamentos é igual. Caso algum tratamento apresente um número inferir de repetições, fato comumente observado em experimentos de campo devido a presença de parcelas perdidas, a DMS deste par de médias em específico deve ser corrigida. Geralmente, as análises complementares são realizadas quando a ANOVA indica significância para um determinado fator de variação, no entanto, o teste Tukey pode revelar diferença entre as médias, mesmo quando o teste F não indicar essa diferença. Isto pode ser observado, principalmente quando a probabilidade de erro for muito próxima de 5%, por exemplo, Pr>Fc = 0.0502. A recíproca também é verdadeira. O teste Tukey pode indicar que as médias não diferem, se Pr>Fc = 0.0492, por exemplo.

Em adição à justificativa anterior (as alterações no rendimento de grão observadas fora resultado do acaso), existem pelo menos mais três razões potenciais para a não regeição da hipótese \(H_0\) em nosso exemplo: (i) um experimento mal projetado com poder insuficiente para detectar uma diferença (à 5% de erro) entre as médias; (ii) os tratamentos foram mal escolhidos e não refletiram adequadamente a hipótese inicial do estudo; ou (iii) o experimento foi indevidamente instalado e conduzido sem supervisão adequada, com baixo controle de qualidade sobre os protocolos de tratamento, coleta e análise de dados. Esta última opção parece ser a mais razoável aqui. É possivel observar no boxplot para o fator bloco que o bloco 4 parece ter uma média superior aos outros blocos. Sabe-ser que no DIC, toda diferença entre as repetições de um mesmo tratamento comporão o erro experimental. Logo, neste exemplo, a área experimental não era homogênea como se pressupunha na instalação do experimento. Isto ficará claro, posteriormente, ao analisarmos o mesmo conjunto de dados, no entanto considerando um .

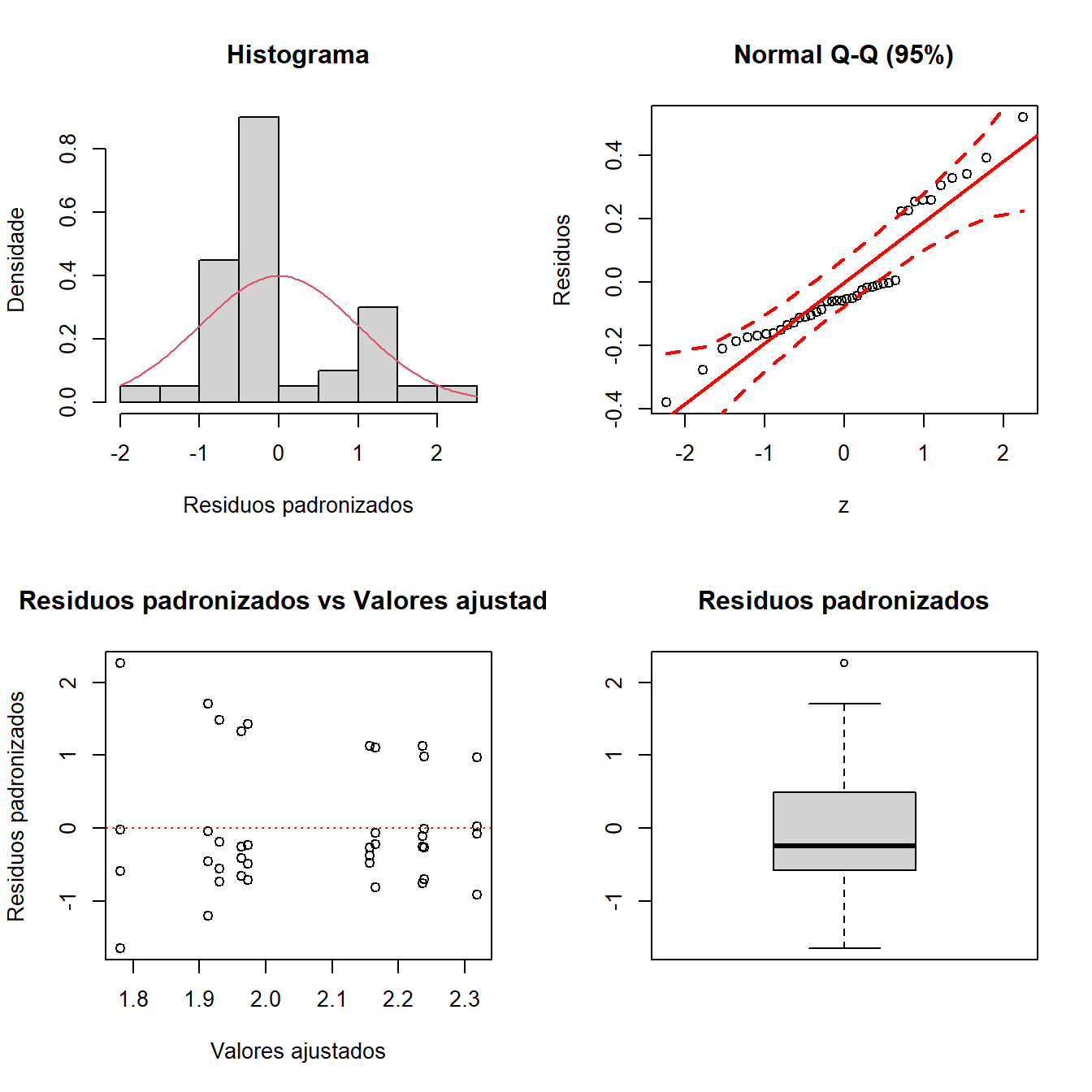

É possível extrair os erros através de mod3$residuos. Também é possível fazer diagnóstico dos pressupostos do modelo estatístico através de gráficos utilizando a função plotres():

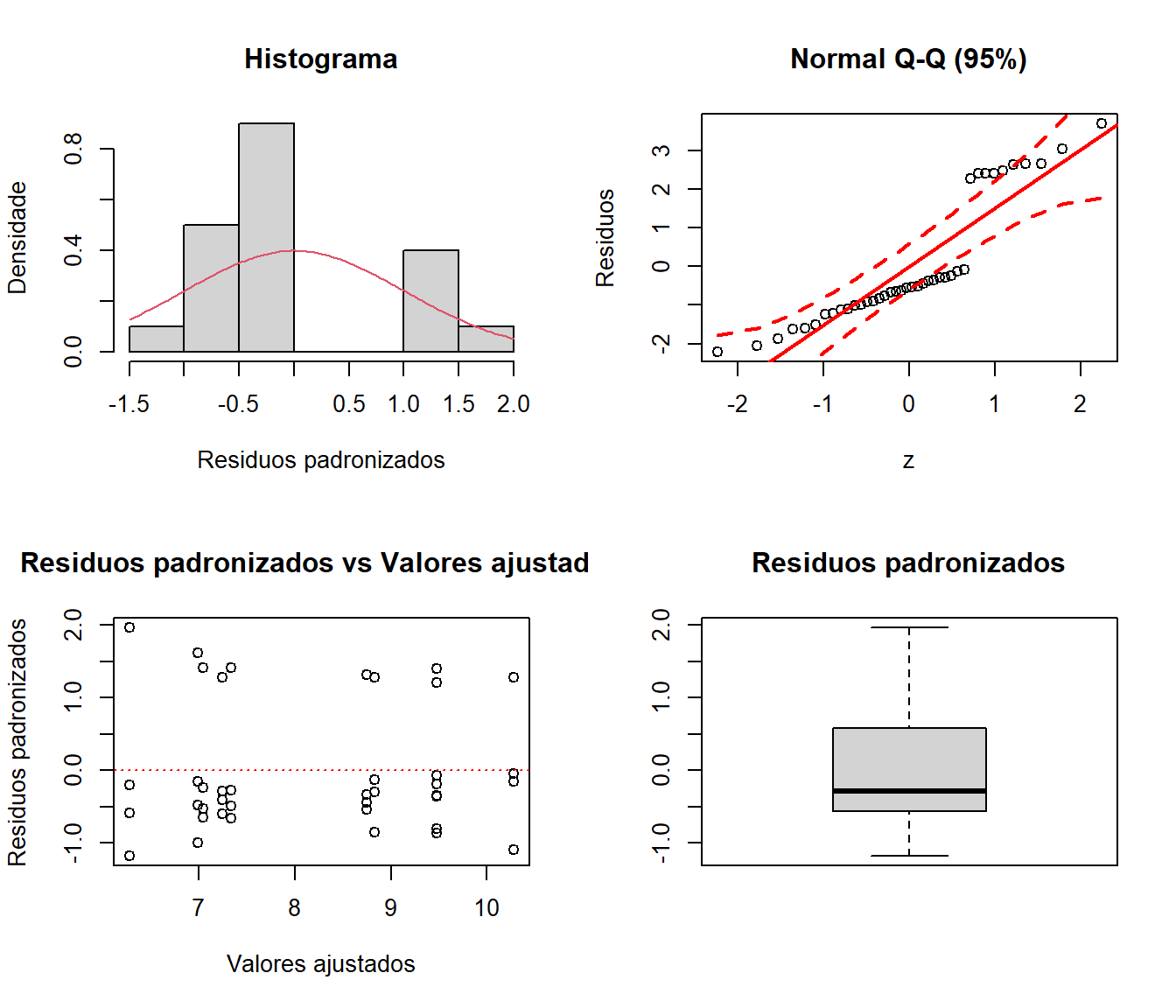

plotres(mod3)

Figure 10.2: Gráfico de resíduos gerado pela função plotres()

O p-valor do teste de Shapiro-Wilk indicou que os resíduos não seguem uma seguem uma distribuição normal, o que pode ser confirmado pelo QQ-Plot. O argumento hvar = "levene" na função é utilizado para testar a homogeneidade dos resíduos. De acordo com o resultado do teste, os resíduos podem ser considerados homogêneos.

Exercício 7

- Utilize os pacotes dplyr e ggplot2 para confeccionar um gráfico de barras onde o eixo y é representado pelos híbridos e o eixo x pelo rendimento de grãos.

- Adicione uma linha vertical tracejada mostrando a média global do experimento.

- Adicione a letra “a” em todas as barras para identificar a não diferença entre as médias.

10.2.5.3 DIC com fatores quantitativos

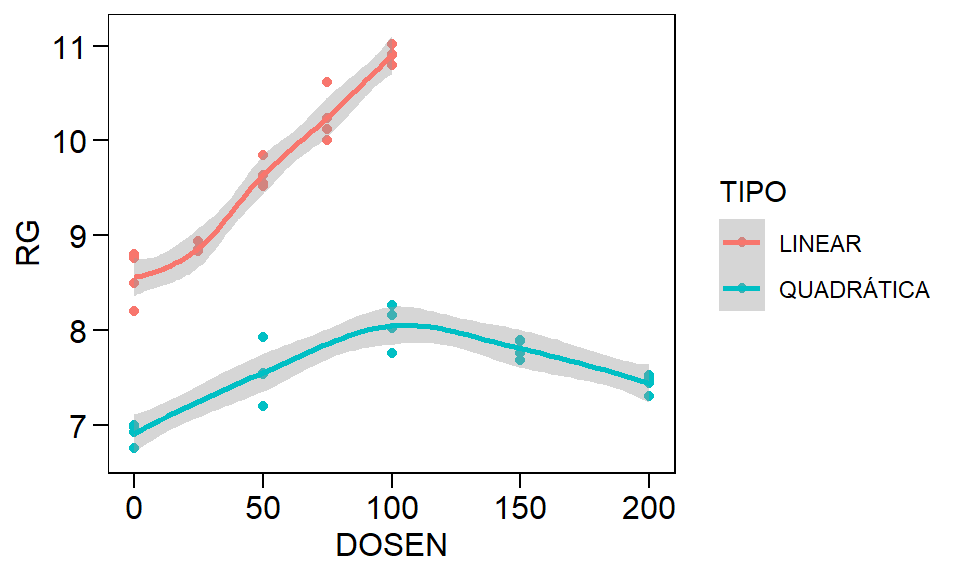

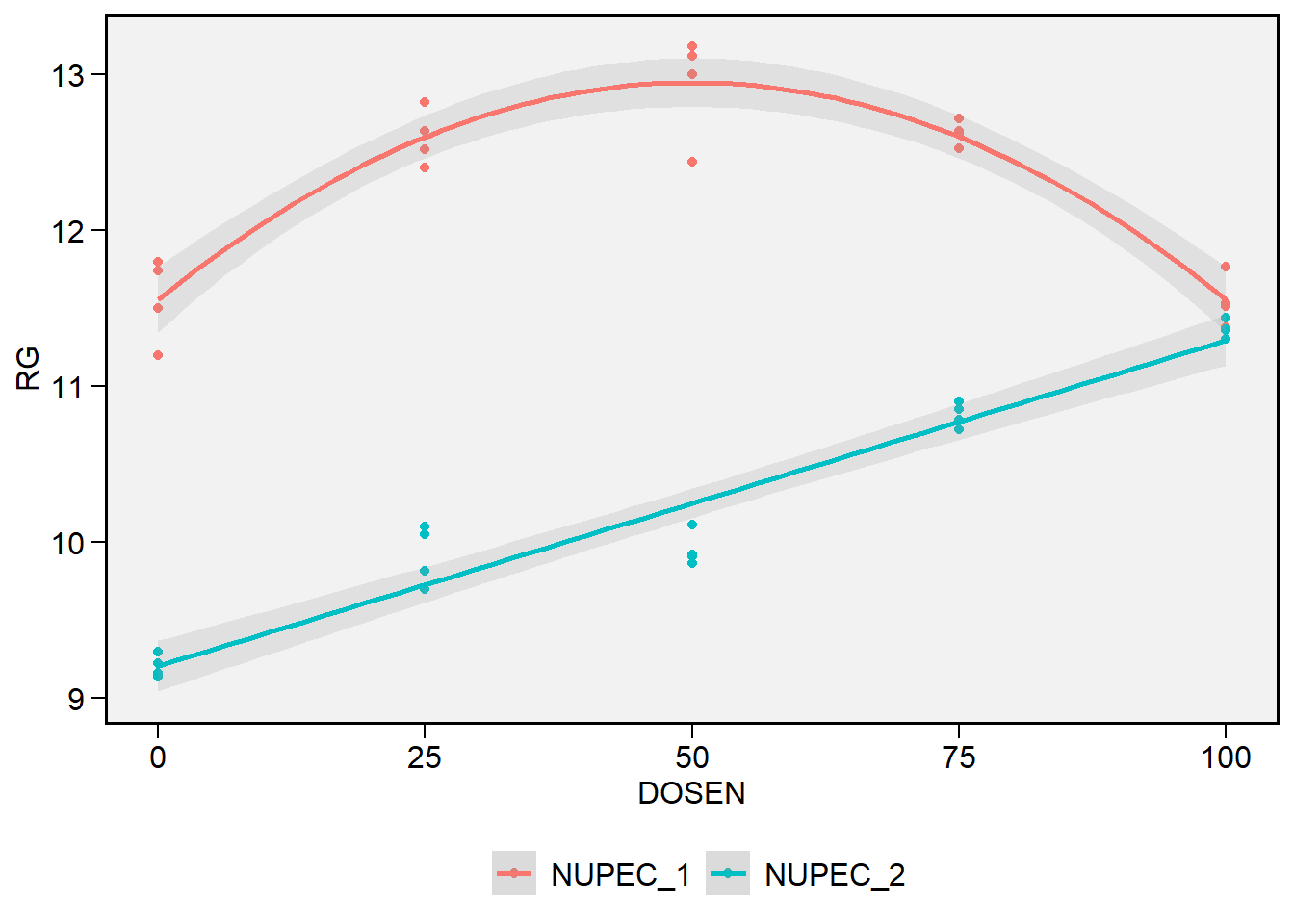

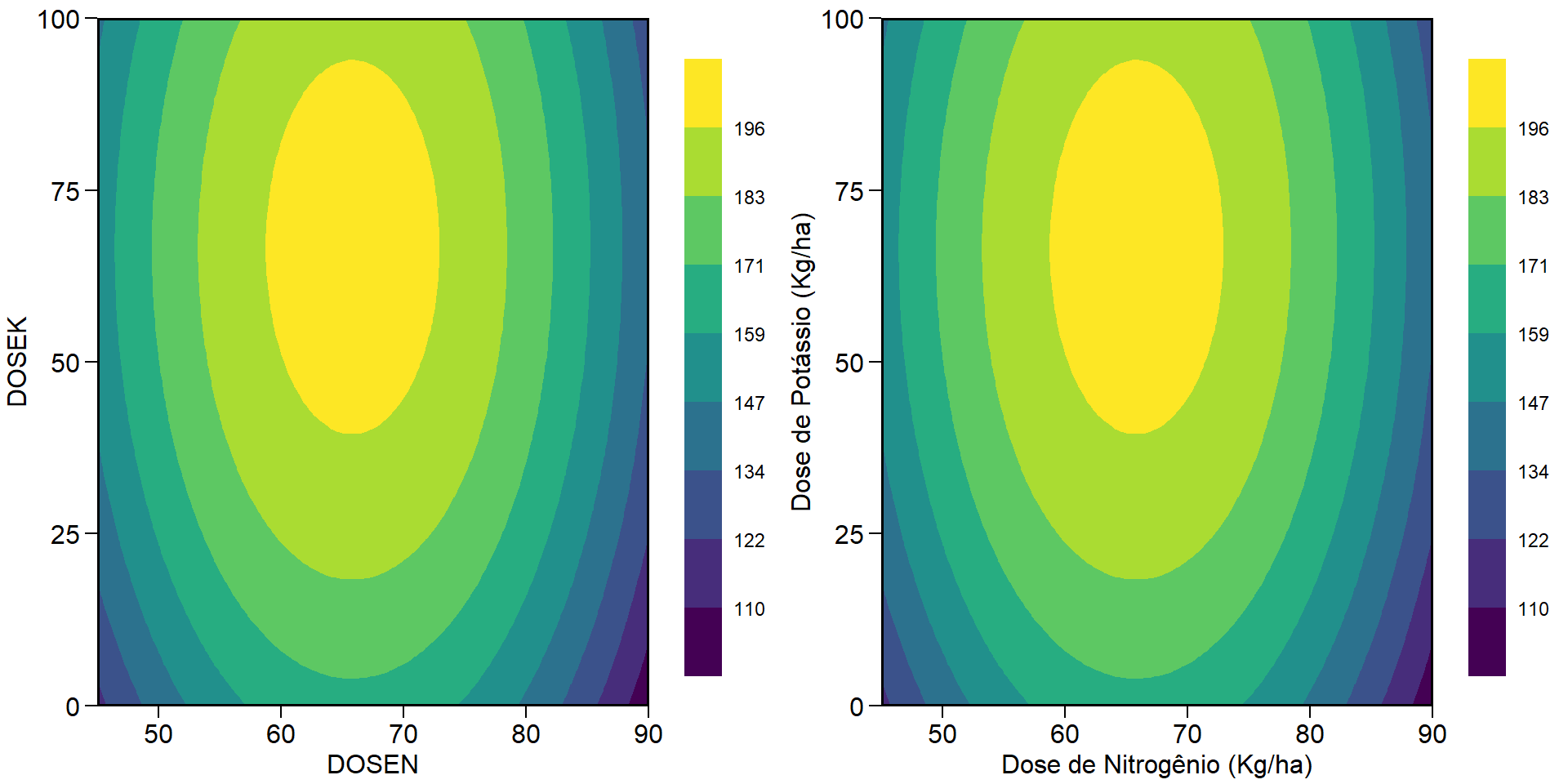

Vimos anteriormente que os fatores qualitativos são comparados através de comparações de médias. No caso de fatores quantitativos, o comum é utilizar regressões como análise complementar. Neste tipo de análise a \(SQ_{Trat}\) é decomposta, e cada polinômio explicará parte desta soma de quadrados. O maior grau significativo do polinômio determinará qual a regressão escolhida. Para implementar essa análise, utilizando a função dic(), basta indicar como FALSE no argumentos quali. O arquivo de dados “QUALITATIVO.xlsx” contém três exemplos, com comportamento linear, quadrático e cúbico. Utilizando o que aprendemos no ggplot2 até agora, vamos criar um gráfico para visualisar estes dados.

url <- "https://github.com/TiagoOlivoto/e-bookr/raw/master/data/data_R.xlsx"

quantitativo_todos <- import(url, sheet = "QUANTI")

ggplot(quantitativo_todos, aes(DOSEN, RG, col = TIPO)) +

geom_point() +

geom_smooth()

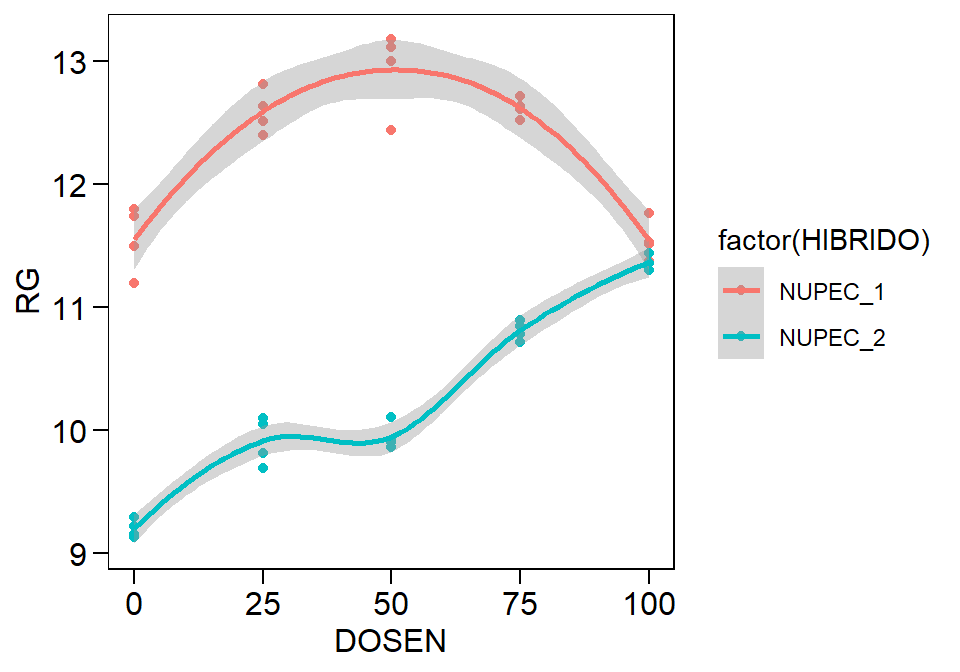

Figure 10.3: Exemplo de regressão com comportamento linear, quadrático e cúbico

Como exemplo didático, vamos analisar os dados que parecem ter comportamento quadrático para ver se, estatisticamente, isto é confirmado. Para isto, utilizamos a função subset() para criar um novo conjunto de dados que contenha somente o nível “QUADRÁTICA” dos nosso dados originais. Para evitar uma longa saída, os resultados desta seção em específico não foram mostrados.

quantitativo <- filter(quantitativo_todos, TIPO == "QUADRÁTICA")

crd_Reg <- with(quantitativo, dic(DOSEN, RG, quali = FALSE, hvar = "levene"))Abaixo vamos reproduzir o exemplo para os usuários das funções aov() ou lm().

Reg <- quantitativo

Total <- aov(RG ~ 1, data = Reg)

Saturado <- aov(RG ~ factor(DOSEN), data = Reg)

Linear <- lm(RG ~ DOSEN, data = Reg)

Quadratica <- lm(RG ~ poly(DOSEN, 2, raw = TRUE), data = Reg)

Cubica <- lm(RG ~ poly(DOSEN, 3, raw = TRUE), data = Reg)

anova(Total, Linear, Quadratica, Cubica, Saturado)

# Analysis of Variance Table

#

# Model 1: RG ~ 1

# Model 2: RG ~ DOSEN

# Model 3: RG ~ poly(DOSEN, 2, raw = TRUE)

# Model 4: RG ~ poly(DOSEN, 3, raw = TRUE)

# Model 5: RG ~ factor(DOSEN)

# Res.Df RSS Df Sum of Sq F Pr(>F)

# 1 19 3.4242

# 2 18 2.7430 1 0.68121 20.3242 0.0004164 ***

# 3 17 0.5862 1 2.15679 64.3488 8.327e-07 ***

# 4 16 0.5861 1 0.00009 0.0027 0.9593568

# 5 15 0.5028 1 0.08332 2.4858 0.1357289

# ---

# Signif. codes: 0 '***' 0.001 '**' 0.01 '*' 0.05 '.' 0.1 ' ' 1O polinômio de segundo grau deve ser o escolhido, pois ele foi o maior grau significativo (p-valor menor que 0,05). Os desvios da regressão nada mais são do que a FALTA DE AJUSTE dos modelos. Porém, como é comum em ciências agrárias, ajusta-se apenas polinômios até a terceira ordem, devido a dificuldade de interpretção de polinômios com ordens superiores. É importante ressaltar que aqui estamos falando de regressões polinomiais. Como será visto posteriormente, a falta de ajuste é inaceitável para modelos de regressão múltipla. O valor de \(R^2\) é dado pela razão entre a \(SQ_{Regressão}\) e a \(SQ_{Tratamento}\). No exemplo acima, o \(R^2\) da regressão quadrática (selecionada) é:

\[ {R^2} = \frac{{S{Q_{{\rm{Regressão}}}}}}{{S{Q_{{\rm{Tratamento}}}}}} = \frac{{2,4900 + 1,5465}}{{4,0505}} = 0.9965 \]

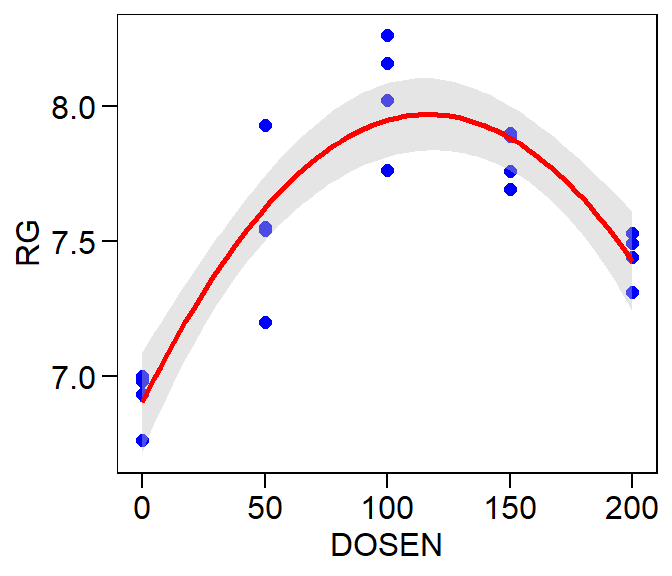

Percebe-se claramente pelos resultados acima que a significância do grau do polinômio está diretamente relacionado com quanto ele “contribui” para explicar a \(SQ_{Trat}\). A forma mais prática de analisar uma regressão é através de gráficos. A função dic() fornece essa alternativa, através da função graphics(). Nesta função existe dois argumentos obrigatórios: a, onde indicamos o objeto que contém a saída da análise do experimento e grau, onde indicamos o grau do polinômio.

Gráfico de resultados: uma proposta

ggplot(quantitativo, aes(x = DOSEN, y = RG))+ # Indicar dados e variáveis

geom_point(color = "blue", size = 2) + # Adiociona e edita os pontos

geom_smooth(method = "lm",

formula = y ~ poly(x, 2, raw = TRUE),

color = "red",

fill = "grey")

Figure 10.4: Gráfico de linhas gerado pela função ggplot()

Este é um exemplo simples de uso da função ggplot(). Porém, como visto até aqui, esta função (mesmo em aplicações simples) tem suas complexidades. Pensando nisso, o pacote metan33 foi desenvolvido e contém funções úteis que facilitam a confeção de gráficos. A partir dos experimentos fatoriais, apenas as funções deste pacote serão utilizados para a confecção dos gráficos.

Exercício 8

- Utilize a função

plot_lines()do pacotemetan** para confeccionar um gráfico semelhante ao anterior. Para maiores detalhes veja?metan::plot_lines.

10.2.6 Delineamento blocos ao acaso (DBC)

No delineamento de blocos ao acaso uma restrição na casualisação é imposta visando agrupar unidades experimentais uniformes dentro de um bloco, de maneira que a heterogeneidade da área experimental fique entre os blocos. O bloquemento tem como objetivo reduzir o erro experimental, “transferindo” parte do erro experimental para efeito de bloco. O modelo do DBC é dado por

\[ {Y_{ij}} = m + {b_j} + {t_i} + {\varepsilon _{ij}} \]

Onde \(m\) é a média geral do experimento, \(b_j\) é o efeito de bloco, \(t_i\) é o efeito de tratamentos e \(\epsilon_{ij}\) é o erro experimental. No pacote ExpDes.pt, este delineamento é executado pela função dbc(). Os argumentos desta função são:

| Argumento | Descrição |

|---|---|

trat |

Objeto contendo os tratamentos |

bloco |

Objeto contendo os blocos |

resp |

Objeto contendo a variável resposta |

quali |

Se TRUE, o tratamento é qualitativo (default) |

mcomp |

Indicar o teste complementar (Tukey é default) |

nl |

Indica se uma regressão deve ser ajustada (FALSE é o default) |

hvar |

Teste de homogeneidade da variância (ONeill e Mathews é o default) |

sigT |

Significância da comparação múltipla (default 0,05) |

sigF |

Significância do teste F (default 0,05) |

Percebe-se que apenas um argumento foi adicionado a função: bloco.

10.2.6.1 DBC com fatores qualitativos

Neste exemplo, vamos realizar a ANOVA com os mesmos dados do exemplo , agrupando as médias pelo teste Scott-Knott utilizando o argumento mcomp = "sk":

mod4 <- with(qualitativo, dbc(HIBRIDO, BLOCO, RG, mcomp = "sk"))

# ------------------------------------------------------------------------

# Quadro da analise de variancia

# ------------------------------------------------------------------------

# GL SQ QM Fc Pr>Fc

# Tratamento 9 65.662 7.296 18.716 2.0298e-09

# Bloco 3 95.642 31.881 81.785 1.1000e-13

# Residuo 27 10.525 0.390

# Total 39 171.828

# ------------------------------------------------------------------------

# CV = 7.64 %

#

# ------------------------------------------------------------------------

# Teste de normalidade dos residuos

# valor-p: 0.6834664

# De acordo com o teste de Shapiro-Wilk a 5% de significancia, os residuos podem ser considerados normais.

# ------------------------------------------------------------------------

#

# ------------------------------------------------------------------------

# Teste de homogeneidade de variancia

# valor-p: 0.2599294

# De acordo com o teste de oneillmathews a 5% de significancia, as variancias podem ser consideradas homogeneas.

# ------------------------------------------------------------------------

#

# Teste de Scott-Knott

# ------------------------------------------------------------------------

# Grupos Tratamentos Medias

# 1 a NP_1 10.27750

# 2 a NP_4 9.48075

# 3 a NP_3 9.48000

# 4 b NP_2 8.83200

# 5 b NP_5 8.75075

# 6 c NP_6 7.33625

# 7 c NP_8 7.24500

# 8 c NP_7 7.04500

# 9 c NP_9 6.99225

# 10 c NP_10 6.28300

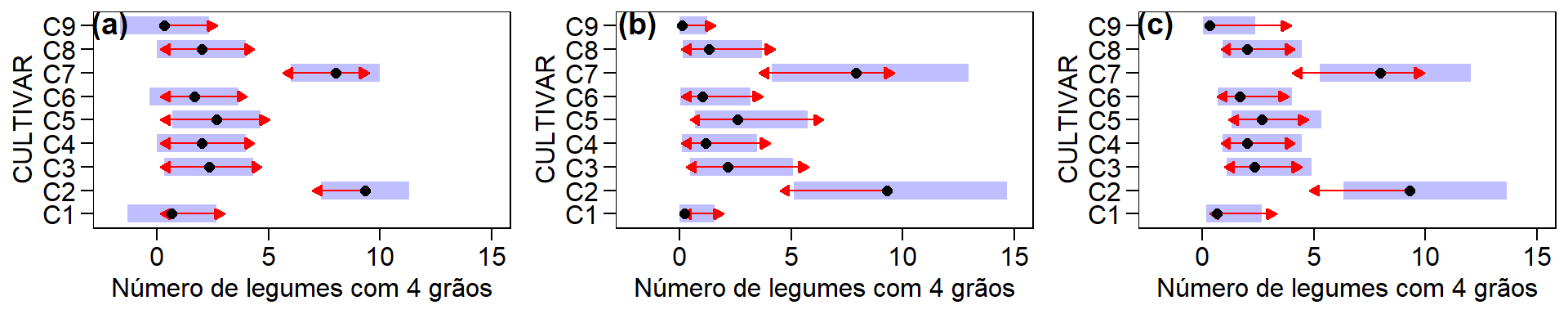

# ------------------------------------------------------------------------Considerando o bloco como um fator de variação no experimento, pode-se afirmar que a média de produtividade difere entre os híbridos testados. Como o efeito de bloco foi significativo Pr>Fc < 0.05, conclui-se que a escolha pelo delineamento em blocos casualizados foi correta, e, principalmente, que a disposição dos blocos na área experimental possibilitou lograr a heterogeneidade entre os blocos, deixando a homogeneidade dentro de cada bloco. O Fc para o fator de tratamento “HÍBRIDOS” foi de 18.716, qual acumula uma probabilidade de erro de somente 0.0000002029.

Incluindo o bloco como fonte de variação nota-se que 3 graus de liberdade (GL) que antes compunham o erro “saíram” e passaram a compor o GL do bloco. Assim, neste exemplo, o GL do erro foi de 27. No entanto, uma grande parte da soma de quadrados do erro (aproximadamente 90%) observada no delineamento DIC era oriunda do efeito de bloco. Com isto, a soma de quadrado do erro considerando o delineamento DBC foi de apenas 10.525 e, mesmo com a “perda” de 3 GL para compor o bloco, o quadrado médio do erro foi de somente 0.390 (89% menor quando comparado com o delineamento DIC). Consequentemente o valor do F calculado para o fator HÍBRIDO foi significativo. Cabe ressaltar que a soma de quadrados para o fator de variação HÍBRIDO não muda se o delineamento for DIC ou DBC.

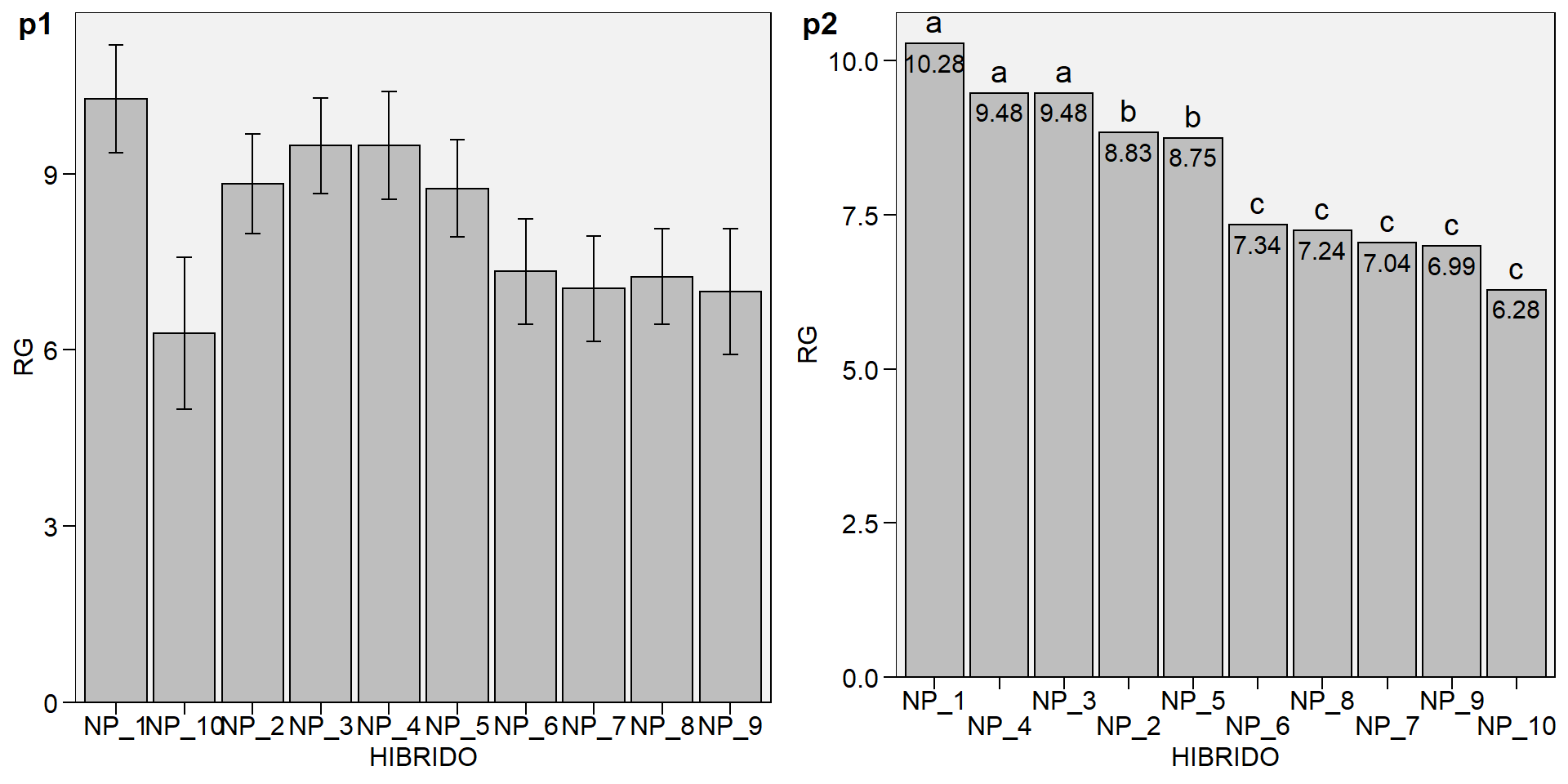

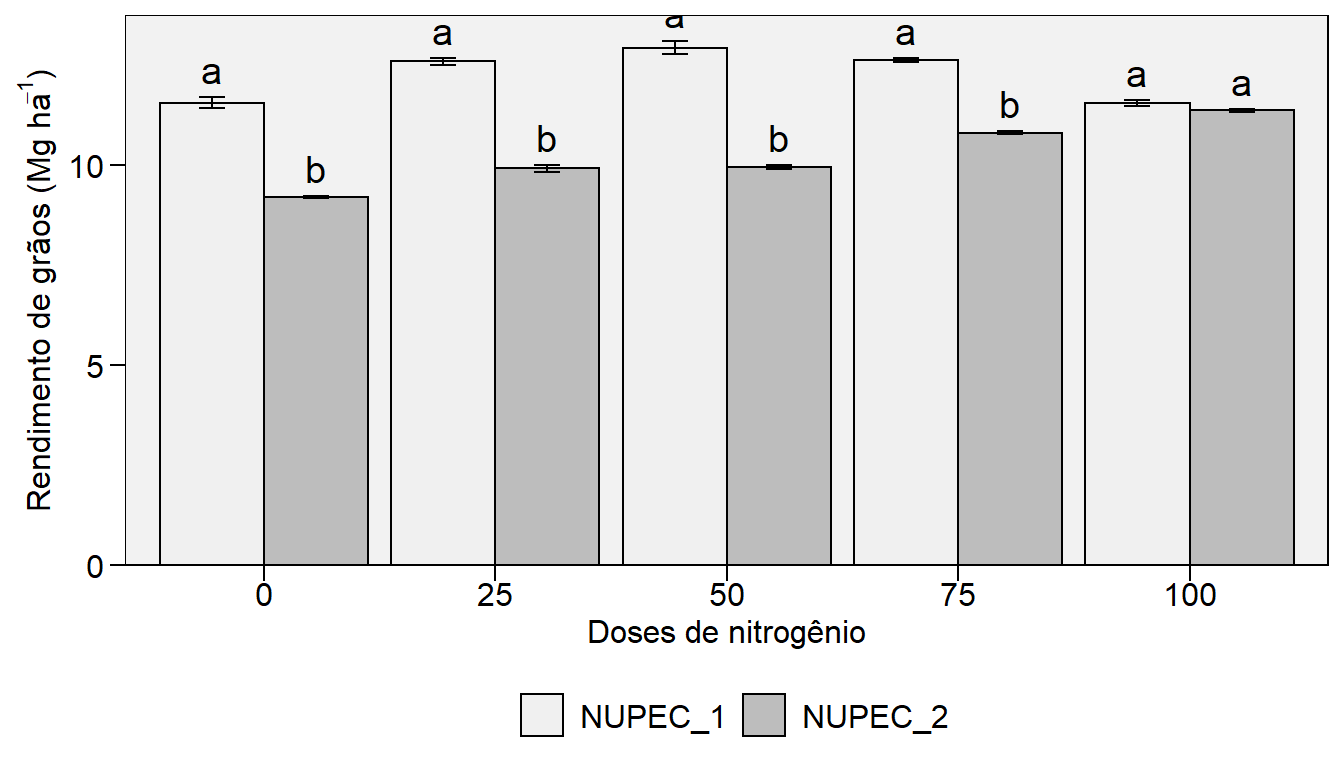

Uma sugestão para apresentação dos dados é a confecção de um gráfico de barras. Para isto, utilizaremos a função plot_bars() do pacote metan. Utilizando o argumento lab.bars é possível adicionar as letras do teste SK. Por padrão, barras de erro mostrando o erro padrão da média são adicionadas. Para suprimir estas barras use errorbar = FALSE. É possível também adicionar os valores às barras usando values = TRUE, ordenar em ordem crescente ou decrescente, bem como modificar a cor e preenchimento das barras facilmente

p1 <- plot_bars(qualitativo, x = HIBRIDO, y = RG)

p2 <- plot_bars(qualitativo,

x = HIBRIDO,

y = RG,

lab.bar = c("a", "c", "b", "a", "a", "b", "c", "c", "c", "c"),

order = "desc",

errorbar = FALSE,

values = TRUE,

n.dodge = 2)

plot_grid(p1, p2, labels = c("p1", "p2"))

10.2.6.2 DBC com fatores quantitativos

Para realizar a análise de regressão considerando um delineamento DBC basta utilizar a função dbc() incluindo o seguinte argumento quali = FALSE.

Exercício 9

Rode a programação para os dados quantitativos considerando o delineamento DBC e compare os resultados com aquela obtida pela função

dic()para os mesmos dados.As estimativas dos parâmetros da regressão são as mesmas?

O p-valor para o testes de hipótese para efeito de tratamento é o mesmo?

10.2.6.3 Análise de experimentos utilizando modelos mistos

A função gamem() do pacote metan pode ser utilizada para analizar dados de experimentos unifatoriais utilizando um modelo misto de acordo com a seguinte equação:

\[ y_{ij}= \mu + \alpha_i + \tau_j + \varepsilon_{ij} \]

onde \(y_ {ij}\) é o valor observado para o i-ésimo genótipo na j-ésima repetição (i = 1, 2, … g; j = 1, 2,. ., r); sendo g e r o número de genótipos e repetições, respectivamente; \(\alpha_i\) é o efeito aleatório do i-ésimo genótipo; \(\tau_j\) é o efeito fixo da j-ésima repetição; e \(\varepsilon_ {ij}\) é o erro aleatório associado a \(y_{ij}\). Neste exemplo, usaremos os dados de exemplo data_g do pacote metan.

gen_mod <- gamem(data_g, GEN, REP,

resp = c(ED, CL, CD, KW, TKW, NKR))

# Method: REML/BLUP

# Random effects: GEN

# Fixed effects: REP

# Denominador DF: Satterthwaite's method

# ---------------------------------------------------------------------------

# P-values for Likelihood Ratio Test of the analyzed traits

# ---------------------------------------------------------------------------

# model ED CL CD KW TKW NKR

# Complete NA NA NA NA NA NA

# Genotype 2.73e-05 2.25e-06 0.118 0.0253 0.00955 0.216

# ---------------------------------------------------------------------------

# Variables with nonsignificant Genotype effect

# CD NKR

# ---------------------------------------------------------------------------A maneira mais fácil de obter os resultados do modelo acima é usando a função get_model_data(). Vamos fazer isso.

- Teste de razão de máxima verossimilhança

get_model_data(gen_mod, "lrt")

# Class of the model: gamem

# Variable extracted: lrt

# # A tibble: 6 x 8

# VAR model npar logLik AIC LRT Df `Pr(>Chisq)`

# <chr> <chr> <dbl> <dbl> <dbl> <dbl> <dbl> <dbl>

# 1 ED Genotype 4 -91.9 192. 17.6 1 0.0000273

# 2 CL Genotype 4 -86.2 180. 22.4 1 0.00000225

# 3 CD Genotype 4 -52.5 113. 2.45 1 0.118

# 4 KW Genotype 4 -165. 339. 5.00 1 0.0253

# 5 TKW Genotype 4 -190. 389. 6.72 1 0.00955

# 6 NKR Genotype 4 -96.3 201. 1.53 1 0.216- Componentes de variância

get_model_data(gen_mod, "genpar")

# Class of the model: gamem

# Variable extracted: genpar

# # A tibble: 11 x 7

# Parameters ED CL CD KW TKW NKR

# <chr> <dbl> <dbl> <dbl> <dbl> <dbl> <dbl>

# 1 Gen_var 5.37 4.27 0.240 181. 841. 2.15

# 2 Gen (%) 68.8 75.1 27.4 39.2 45.2 21.6

# 3 Res_var 2.43 1.41 0.634 280. 1018. 7.80

# 4 Res (%) 31.2 24.9 72.6 60.8 54.8 78.4

# 5 Phen_var 7.80 5.68 0.873 461. 1859. 9.94

# 6 H2 0.688 0.751 0.274 0.392 0.452 0.216

# 7 h2mg 0.869 0.901 0.532 0.659 0.712 0.452

# 8 Accuracy 0.932 0.949 0.729 0.812 0.844 0.673

# 9 CVg 4.84 7.26 3.10 9.16 9.13 4.82

# 10 CVr 3.26 4.18 5.05 11.4 10.0 9.19

# 11 CV ratio 1.49 1.74 0.615 0.803 0.909 0.525- Médias preditas

get_model_data(gen_mod, "blupg")

# Class of the model: gamem

# Variable extracted: blupg

# # A tibble: 13 x 7

# GEN ED CL CD KW TKW NKR

# <chr> <dbl> <dbl> <dbl> <dbl> <dbl> <dbl>

# 1 H1 50.2 30.7 15.8 153. 354. 29.5

# 2 H10 44.4 25.1 15.5 129. 268. 31.7

# 3 H11 47.2 26.6 15.6 143. 297. 31.3

# 4 H12 47.8 26.1 15.2 148. 293. 30.0

# 5 H13 50.3 27.4 15.9 170. 319. 31.2

# 6 H2 50.3 30.0 16.3 156. 338. 29.6

# 7 H3 47.2 28.6 16.1 142. 331. 30.2

# 8 H4 46.1 27.8 16.2 145. 310. 31.8

# 9 H5 49.8 30.1 16.2 156. 309. 31.3

# 10 H6 49.7 31.6 15.2 140. 325. 28.6

# 11 H7 48.7 30.0 15.5 153. 346. 30.0

# 12 H8 46.3 29.0 15.8 143. 339. 29.5

# 13 H9 44.4 27.0 15.8 131. 301. 30.4No exemplo acima, o design experimental foi o de blocos completos casualizados. Também é possível analisar um experimento conduzido em alfa-lattice com a função gamem(), baseado na seguinte equação:

\begin{gather} y_{ijk}= \mu + \alpha_i + \gamma_j + (\gamma \tau)_{jk} + \varepsilon_{ijk} \end{gather}

onde \(y_ {ijk}\) é o valor observado do i-ésimo genótipo no k-ésimo bloco da j- ésima repetição (i = 1, 2, … g; j = 1, 2, .., r; k = 1, 2, .., b); respectivamente; \(\alpha_i\) é o efeito aleatório do i-ésimo genótipo; \(\gamma_j\) é o efeito fixo da j-ésima repetição; \((\gamma \tau)_{jk}\) é o efeito aleatório do k-ésimo bloco incompleto aninhado na repetição j; e \(\varepsilon_{ijk}\) é o erro aleatório associado a \(y_{ijk}\). Neste exemplo, usaremos os dados de exemplo data_alpha do pacote metan.

gen_alpha <- gamem(data_alpha, GEN, REP, YIELD, block = BLOCK)

# Method: REML/BLUP

# Random effects: GEN, BLOCK(REP)

# Fixed effects: REP

# Denominador DF: Satterthwaite's method

# ---------------------------------------------------------------------------

# P-values for Likelihood Ratio Test of the analyzed traits

# ---------------------------------------------------------------------------

# model YIELD

# Complete NA

# Genotype 1.18e-06

# rep:block 3.35e-03

# ---------------------------------------------------------------------------

# All variables with significant (p < 0.05) genotype effect

get_model_data(gen_alpha, "lrt")

# Class of the model: gamem

# Variable extracted: lrt

# # A tibble: 2 x 8

# VAR model npar logLik AIC LRT Df `Pr(>Chisq)`

# <chr> <chr> <int> <dbl> <dbl> <dbl> <dbl> <dbl>

# 1 YIELD Genotype 5 -58.4 127. 23.6 1 0.00000118

# 2 YIELD rep:block 5 -50.9 112. 8.61 1 0.00335

get_model_data(gen_alpha, "details")

# Class of the model: gamem

# Variable extracted: details

# # A tibble: 6 x 2

# Parameters YIELD

# <chr> <chr>

# 1 Ngen 24

# 2 OVmean 4.4795

# 3 Min 2.8873 (G03 in B6 of R3)

# 4 Max 5.8757 (G05 in B1 of R1)

# 5 MinGEN 3.3431 (G03)

# 6 MaxGEN 5.1625 (G01)

get_model_data(gen_alpha, "genpar")

# Class of the model: gamem

# Variable extracted: genpar

# # A tibble: 13 x 2

# Parameters YIELD

# <chr> <dbl>

# 1 Gen_var 0.143

# 2 Gen (%) 48.5

# 3 rep:block_var 0.0702

# 4 rep:block (%) 23.8

# 5 Res_var 0.0816

# 6 Res (%) 27.7

# 7 Phen_var 0.295

# 8 H2 0.485

# 9 h2mg 0.798

# 10 Accuracy 0.893

# 11 CVg 8.44

# 12 CVr 6.38

# 13 CV ratio 1.3210.3 Transformação de dados

Em todos os exemplos apresentados até aqui, os resíduos devem cumprir os seguintes pressupsotos: normalidade, homocedasticidade e independência:

\[ {\boldsymbol{\varepsilon }} \sim {\rm N}\left( {0,{\boldsymbol{I}}{\sigma ^2}} \right) \]

Esses pressupostos são necessários para que o teste F seja utilizado na análise de variância. Sob normalidade dos resíduos e hipótese nula \(H_0\), a razão entre as somas de quadrado de tratamento e resíduo tem distribuição F (Rencher and Schaalje 2008). Já em condições de não normalidade dos resíduos, o poder do teste (probabilidade de rejeitar \(H_0\)) é reduzido. Apesar disso, não há grandes mudanças no erro tipo I quando a pressuposição de normalidade é violada (Senoglu and Tiku 2001), e por isso ele é considerado robusto.

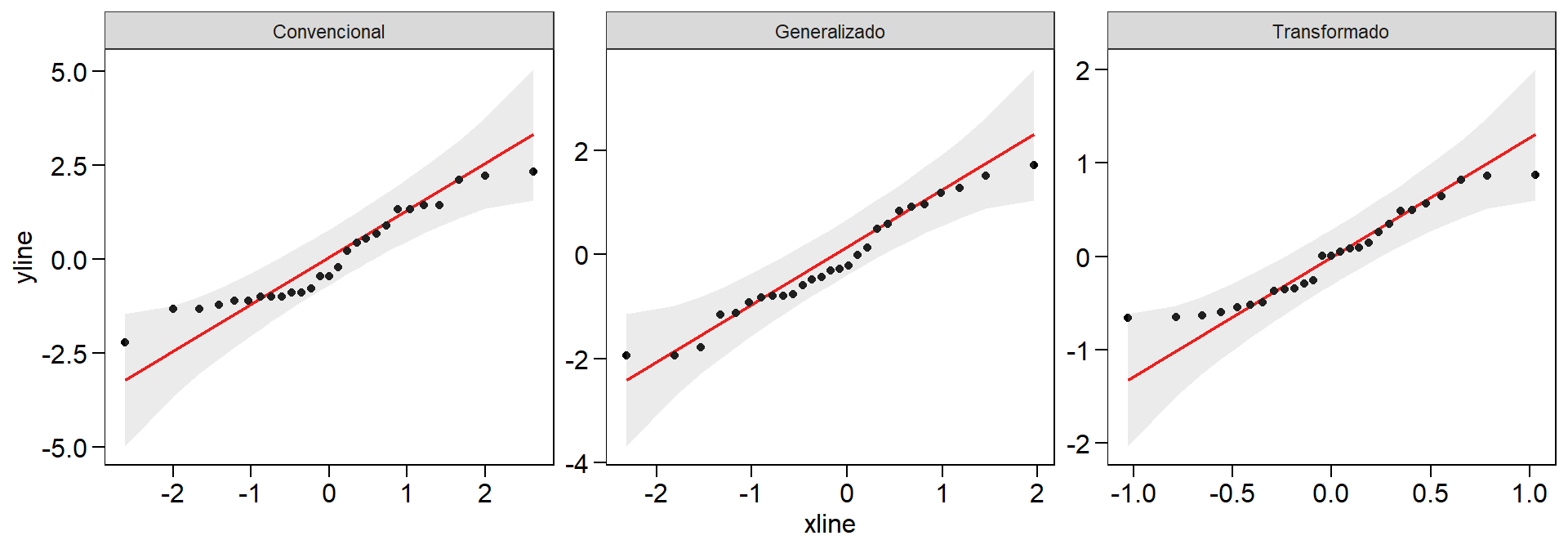

Apesar do teste F de ser robusto a desvios da normalidade, é comum que ela seja cumprida para que o teste seja aplicado. Quando as pressuposições não são cumpridas, um dos procedimentos mais comum é transformar os dados. A transformação Box-Cox (Box and Cox 1964) é uma das mais comuns. Ela consiste em transformar os valores de \(Y_i\) por \(Y_i(\lambda)\), sendo o valor de \(\lambda\) estimado por máxima verossimilhança. Após a transformação de \(Y_i\) por \(Y_i(\lambda)\) os dados seguem distribuição normal com variância constante.

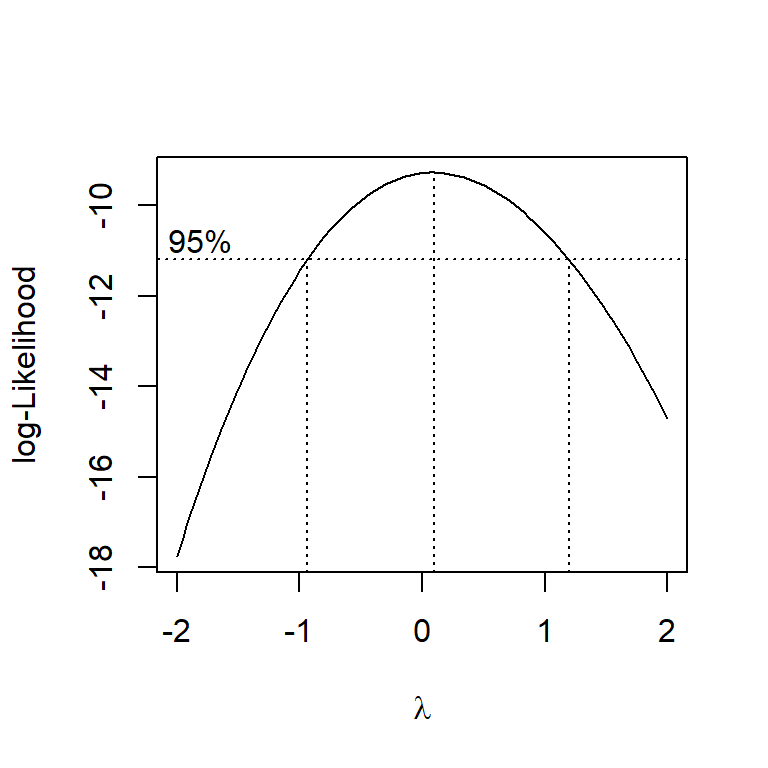

A função boxcox() , do pacote MASS, pode ser utilizada para estimar o valor de \(\lambda\). Uma sequência de valores de \(\lambda\) são estimados, e o escolhido é aquele que maximiza a função de log-verossimilhança. No modelo considerando o delineamento inteiramente casualizado (qualitativo), o pressuposto de normalidade foi violado. O próximo passo é encontrar o valor de \(\lambda\) para transformar a variáveis, utilizando para isso a função boxcox().

MASS::boxcox(RG ~ HIBRIDO, data = qualitativo,

lambda = seq(-2, 2, length = 20)) # Indica os valores de lambda

Figure 10.5: Gráfico gerado pela função boxcox() para identificar o valor de lambda

Percebe-se que o intervalo de \(\lambda\) cruza pelo valor zero, indicando que a transformação log é a mais adequada. Uma forma mais prática de encontrar o valor de \(\lambda\) que maximiza a função de log-verossimilhança é utilizar a função locator() . Após executar a função abaixo, basta clicar com o cursor sobre o ponto que maximiza a função para que as coordenadas sejam mostradas no console.

locator(n = 1)

Utilizando a transformação log(), os resíduos ainda continuaram sendo não normais, apesar de se aproximaram mais da distribuição normal neste caso. Quando a transformação não for eficiente, recomenda-se a utilização de testes não paramétricos, por exemplo, no caso de um delineamento inteiramente casualizado, o teste de Kruskal-Wallis ou de um delineamento de blocos completos casualisados, o teste de Friedman.

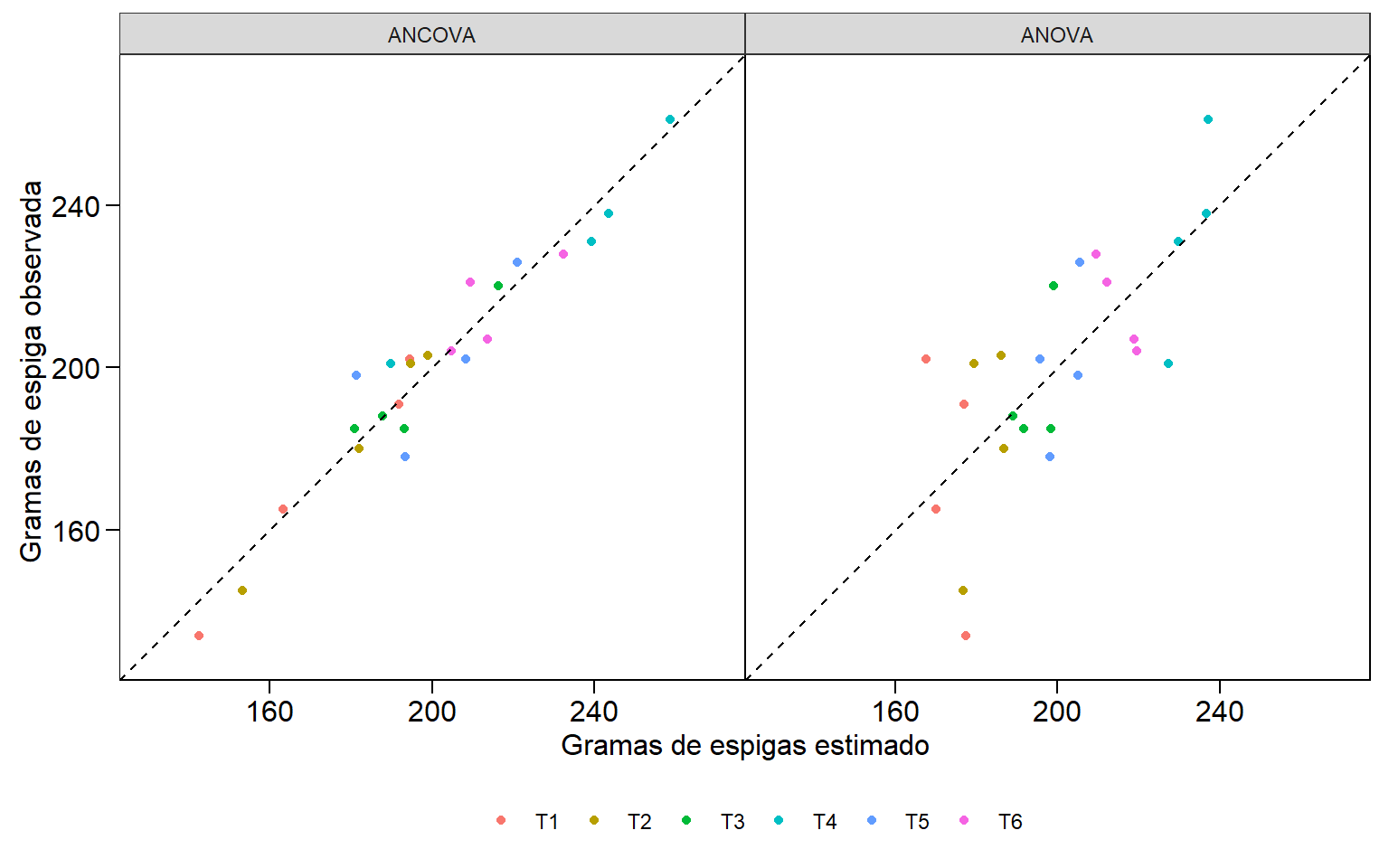

10.4 Análise de covariância (ANCOVA)

10.4.1 Introdução

Neta seção, veremos alguns conceitos estatísticos e uma aplicação numérica de uma técnica interessante que pode ser útil, se corretamente utilizada, para reduzir o erro experimental em experimentos agronômicos: a análise de covariância (ANCOVA). A ANCOVA é um modelo linear geral que combina princípios de ANOVA e regressão para avaliar se as médias de uma variável dependente são iguais entre níveis de uma variável independente categórica (tratamento), controlando estatisticamente os efeitos de outras variáveis contínuas que não são de interesse primário. Tais variáveis contínuas são medidas em cada unidade experimental e são chamadas covariáveis. Idealmente, estas variáveis devem ser determinadas antes que os tratamentos tenham sido atribuídos às unidades experimentais ou, no mínimo, que os valores das covariáveis não sejam afetados pelos tratamentos aplicados (Snedecor and Cochran 1967). A ANCOVA tem várias aplicações. No contexto da experimentação agronômica, ela é frequentemente utilizada reduzir a variabilidade no experimento pela contabilização da variabilidade nas unidades experimentais que não puderam ser controladas pelo design experimental.

Considere um experimento conduzido em uma área em que as unidades experimentais exibem considerável variabilidade que não pode ser controlada utilizando estratégias de bloqueio. O pesquisador acredita, digamos, baseado em experiências passadas, que uma ou mais características das unidades experimentais podem ajudar a descrever parte da variabilidade entre as unidades experimentais. Nesta condição, o pesquisador pode utilizar resultados de experimentos passados observados nas mesmas unidades experimentais –excluido o efeito de tratamento– como uma covariável. Outra estratégia –embora um pouco distante em tempos de recursos financeiros limitados– poderia ser a realização de uma análise de solo em cada unidade experimental e utilizar os resultados obtidos como covariáveis. Neste sentido, ao utilizar informações relacionadas as características fisico-químicas do solo como uma covariável, o pesquisador tenta explicar a variabilidade nas unidades experimentais que não podem ser convenientemente controladas por outra técnica experimental.

10.4.2 Modelo estatístico

Em uma estrura de tratamentos fixos, unifatorial, conduzidos em delineamento inteiramente casualizado, o modelo da ANOVA tradicional visto anteriormente pode ser escrito da seguinte forma quando uma covariável numérica (\(X\)) também foi mensurada em cada unidade experimental.

\[ Y_{ij} = \mu + \tau_i + \beta(X_{ij} - \bar X_{..}) + \varepsilon_{ij} \]

onde \(Y_{ij}\) é a o valor observado do i-ésimo tratamento na j-ésima repetição; \(\mu\) é a média geral; \(\tau_i\) é o efeito do i-ésimo tratamento; \(\beta\) é o coeficiente de regressão de Y em X e \(\varepsilon_{ij}\) é o erro aleatório.

As pressuposições do modelo da ANCOVA são as mesmas que a ANOVA, ou seja, aditividade dos efeitos de bloco e tratamento (em DBC), normalidade, homogeneidade e independêcia dos resíduos, em adição à duas importantes considerações adicionais: (i) independência entre a covariável e o efeito do tratamento; e (ii) homogeneidade dos coeficientes angulares da regressão, que serão tratados à partir daqui como slopes. Considerando que os pressupostos da ANOVA já são conhecidos, veremos com mais detalhes estes dois últimos à seguir.

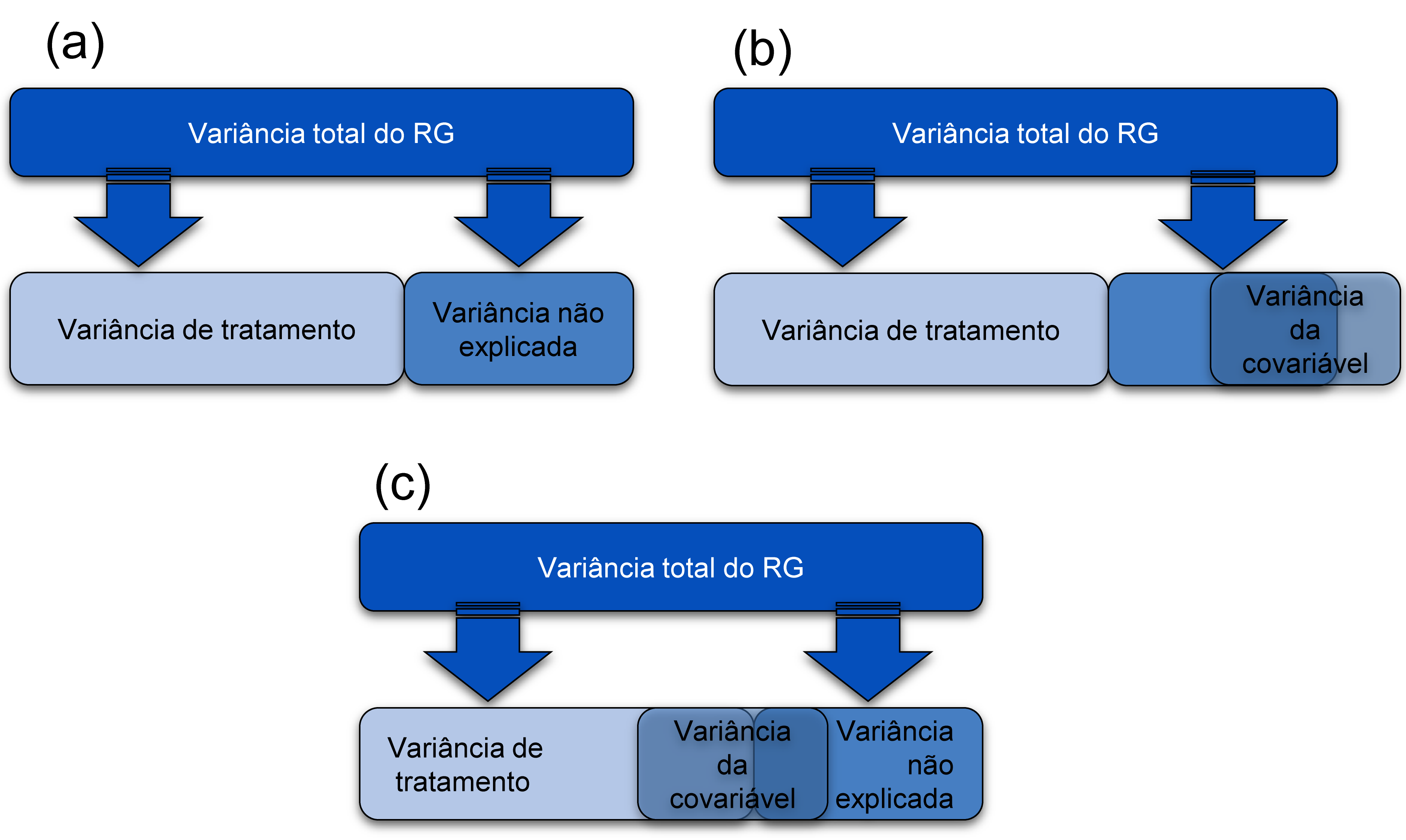

10.4.3 Independência entre a covariável e os efeitos de tratamento

Vimos anteriormente que covariável deve ser independente do efeito do tratamento. A figura 6 mostra três diferentes cenários. No primeiro (a) a represetação esquemática de um delineamento unifatorial conduzido em DIC é mostrada. Neste exemplo, a variância da variável resposta (RG) pode ser dividida em duas partes. Uma correspondente aos efeitos dos tratamentos e a outra devido ao erro experimental, ou variância não explicada pelos tratamentos. Aqui, vimos novamente que toda variância não explicada pelos termos do modelo irá compor o erro experimental. No segundo exemplo (b) um cenário ideal para ANCOVA é representado. Nesta condição, a covariável compartilha sua variância apenas com o pouco da variância do RG que é atualmente inexplicado pelos efeitos dos tratamentos . Em outras palavras, é completamente independente dos tratamentos. Este cenário é o único em que a ANCOVA tradicional é apropriada.

Regra para análise de covariância

O terceiro exemplo, (c) representa uma situação em que as pessoas costumam usar a ANCOVA quando não deveriam. Nesta situação, o efeito da covariável se sobrepõe ao efeito do tratamento. Em outras palavras, o efeito do tratamento é confundido com o efeito da covariável. Em situções como esta, a covariável reduzirá (estatisticamente falando) o efeito do tratamento, pois explica uma parte da variação que seria atribuída ao efeito de tratamento. Assim, efeitos espúrios de tratamento podem surgir, comprometendo a interpretação da ANCOVA (Stevens 2009).

A ANCOVA nem sempre é uma solução magica. O problema do compartilhamento da variância da covariável com a variância de tratamento é comum e muitas vezes é ignorado ou incompreendido pelos pesquisadores (Miller and Chapman 2001). Em uma ampla revisão, Miller e Chapman citam muitas situações em que as pessoas aplicam a ANCOVA de maneira incorreta. Recomendamos a leitura deste artigo. Felizmente, modelos generalizados de ANCOVA que permitem tratar esta interação tratamento-covariável têm sido desenvolvidos (Mayer et al. 2014), mas isto está além do objetivo deste material.

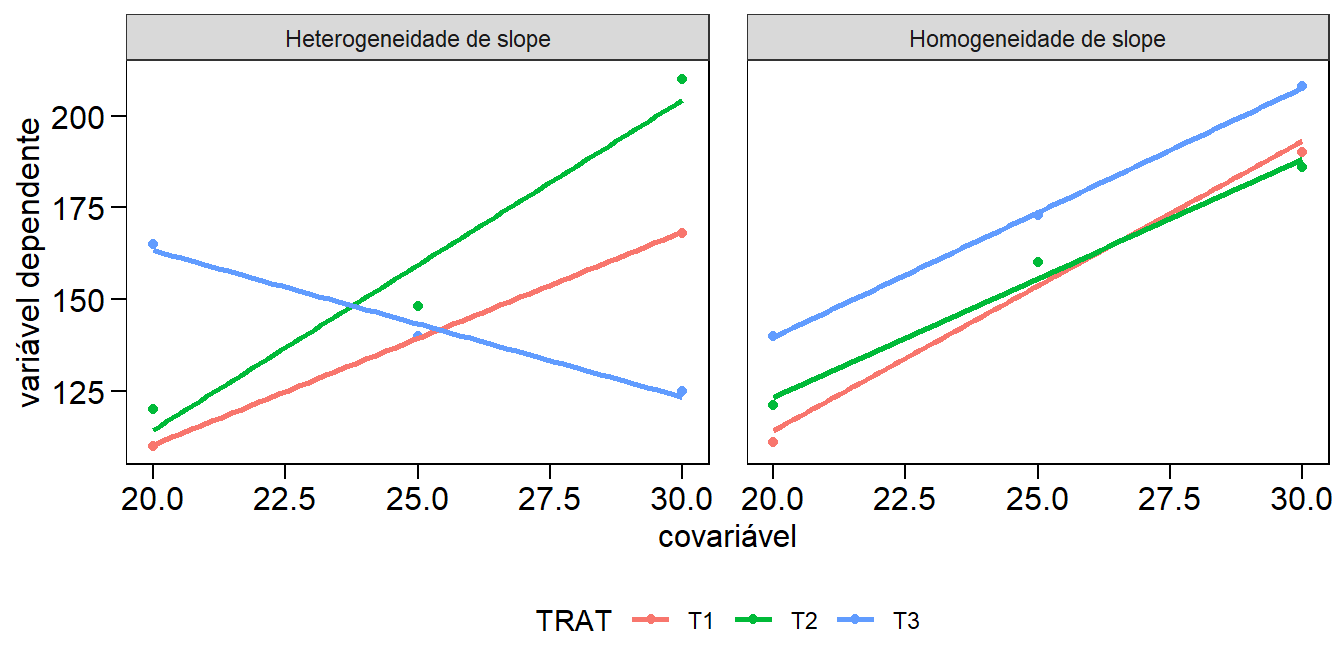

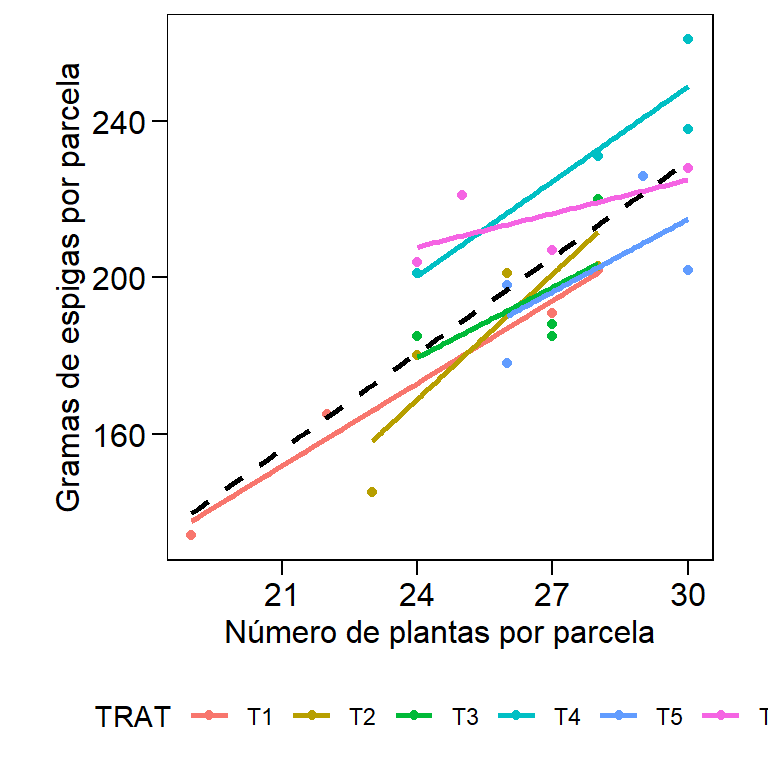

10.4.4 Homogeneidade dos slopes da regressão

Baseado no modelo estatístico apresentado, percebe-se que quando uma ANCOVA é realizada, buscamos uma relação geral entre a variável dependente e a covariável; ou seja, uma regressão global é ajustada aos dados, ignorando à que nível do tratamento uma determinada obsevação pertence. Ao ajustar esse modelo geral, supomos, portanto, que essa relação geral seja verdadeira para todos os níveis do fator tratamento. Por exemplo, se houver uma relação positiva (slope positivo) entre a covariável e a variável dependente no primeiro nível (\(T_1\)), presumimos que há uma relação positiva (slope positivo) em todos os outros níveis também. Vamos tentar tornar esse conceito um pouco mais concreto. A figura 7 mostra um gráfico de dispersão que exibe uma relação hipotética entre a covariável e a variável dependente em duas condições: heterogeneidade de slope (esquerda) e homogeneidade de slope (direita). Na primeira condição, a relação entre a variável dependente e covariável é positiva para os tratamentos \(T_1\) e \(T_2\), mas para o \(T_3\), esta relação parece ser negativa. Esta é uma condição em que a utilização da ANCOVA não é indicada. Na segunda condição, a relação entre a variável dependente e a covariável é muito semelhante entre os tratamentos.

Figure 10.6: Gráfico de dispersão e linhas de regressão entre a variável dependente e a covariável. As diferentes cores represetam três tratamentos hipotéticos.

10.4.5 Um exemplo numérico

Até aqui, passamos por uma breve introdução abordando o modelo mais simples de ANCOVA. Esta técnica, no entanto, pode ser utilizada em qualquer delineamento experimental. Para maiores informações, recomendamos a leitura de três bons materiais: (Rutherford 2001), um livro específico para ANCOVA; (Field, Miles, and Field 2012), pp. 462, com aplicação em R; e (Scheiner and Gurevitch 2001), pp. 77, com aplicação em SAS.

Vamos agora, utilizando um exemplo numérico, demonstrar como esta análise pode ser realizada no software R e identificar como ela pode ser útil na análise de experimentos agronônicos. Os dados são apresentados em (Snedecor and Cochran 1967), pp. 428 e são resultantes de um experimento com 6 tratamentos (cultivares), conduzido em DBC com 4 blocos. A variável resposta mensurada em cada unidade experimental foi gramas de espigas (GE) em adição a uma covariável, número de plantas por unidade experimental (NPLA). Para realizar uma ANCOVA, recomendamos que as seguintes etapas sejam seguidas:

Assumindo que o R será utilizado, insira os dados e instale os pacotes necessários.

Explore os seus dados: Faça uso de gráficos para explorar o padrão encontrado nos dados. A sugestão aqui é utilizar gráficos do tipo boxplot, visto a riqueza de informações proporcionada por este tipo de gráficos.

Verifique se a covariável e os tratamentos são independentes: Execute uma ANOVA com a covariável como o variável dependente para verificar se a covariável não difere significativamente entre os níveis da variável independente (tratamento). Se um resultado significativo for observado, interrompa a análise aqui.

A ANCOVA: assumindo que tudo estava bem nas etapas 2 e 3, execute a análise principal de covariância.

Verifique a homogeneidade dos slopes da regressão: execute novamente a ANCOVA, incluindo, agora, a interação entre a variável independente e a covariável. Se esta interação é significativa, então você não pode assumir a homogeneidade dos slopes da regressão.

Compute as análises complementares: encontrada diferença significativa para tratamento na etapa 4 e assumindo que a etapa 5 indicou homogeneidade dos slopes da regressão, as análises complementares –como comparações múltiplas de médias– podem então ser realizadas.

Vamos agora ver cada uma destas etapas detalhadamente.

1. Download dos dados e pacotes necessários

O seguinte código é utilizado para instalar/carregar os pacotes necessários bem como para fazer o upload dos dados e armazenar no dataframe covar

url <- "https://github.com/TiagoOlivoto/e-bookr/raw/master/data/data_R.xlsx"

# dados

covar <- import(url, sheet = "COVAR")

# duas primeiras colunas como fator

covar <- as_factor(covar, 1:2)

covar_ggplot <-

covar %>%

pivot_longer(names_to = "variable", values_to = "val", cols = c(NPUE, GE))

# Estrutura dos dados

covar_ggplot

# # A tibble: 48 x 4

# TRAT BLOCO variable val

# <fct> <fct> <chr> <dbl>

# 1 T1 1 NPUE 28

# 2 T1 1 GE 202

# 3 T1 2 NPUE 22

# 4 T1 2 GE 165

# 5 T1 3 NPUE 27

# 6 T1 3 GE 191

# 7 T1 4 NPUE 19

# 8 T1 4 GE 134

# 9 T2 1 NPUE 23

# 10 T2 1 GE 145

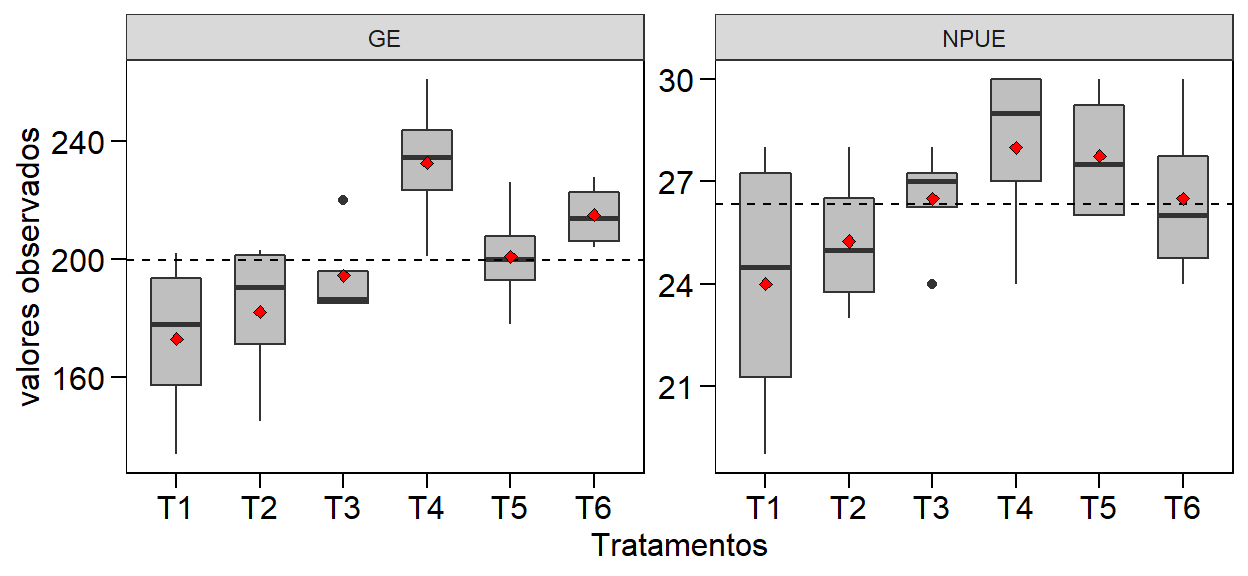

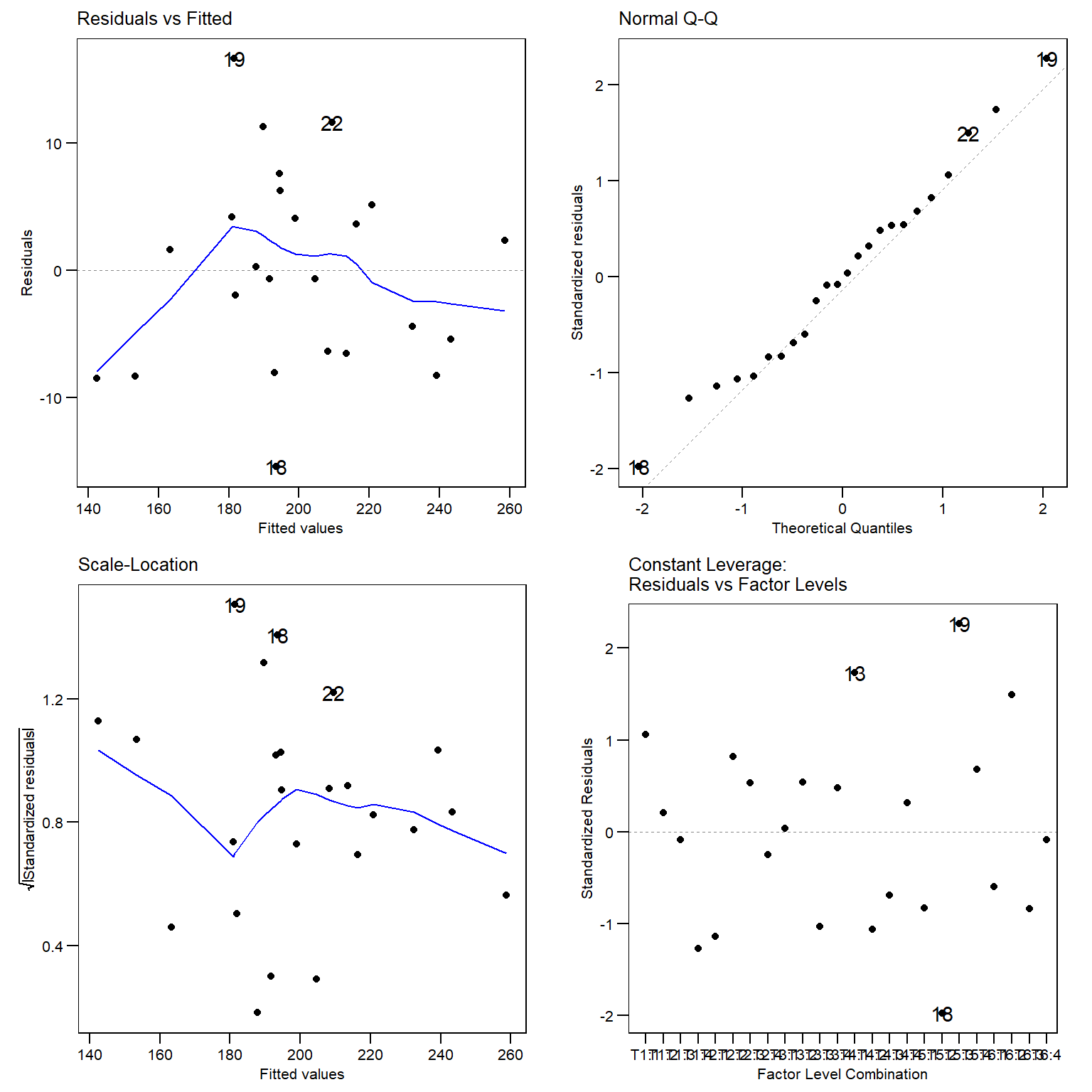

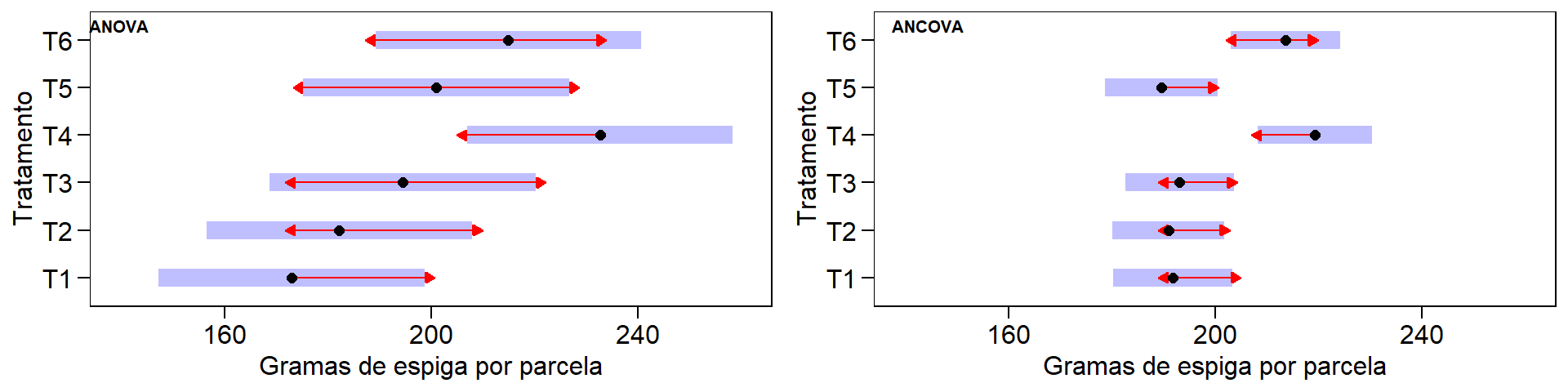

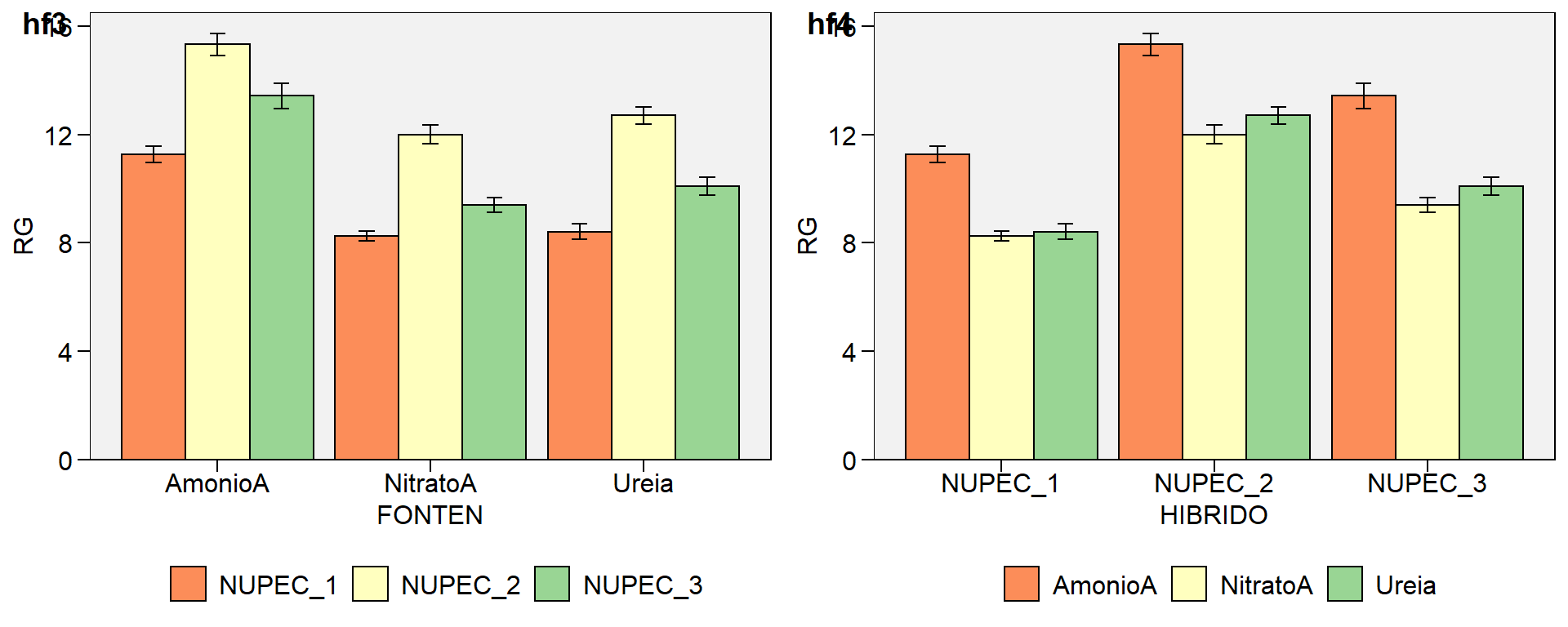

# # ... with 38 more rows2. Explorando os dados

A construção de gráficos do tipo boxplot para a variável resposta e a covariável são importantes, pois permitem identificar a presença de possíveis outliers nos dados além de facilitar a visualização de padrões de associação entre as variáveis.

mean_var <-

covar_ggplot %>%

group_by(variable) %>%

summarise(mean = mean(val))

ggplot(covar_ggplot, aes(x = TRAT, y = val)) +

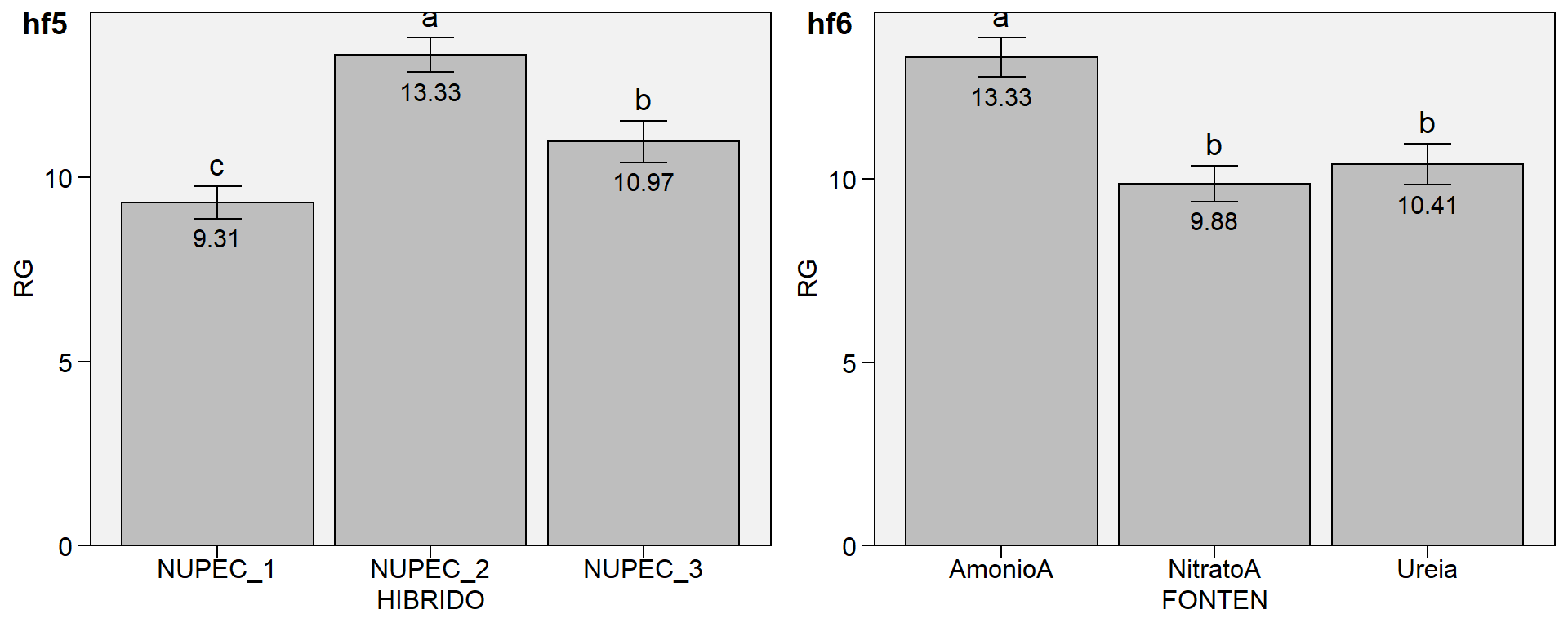

geom_boxplot(fill = "gray75", width = 0.6) +